윈디하나의 블로그

윈디하나의 누리사랑방. 이런 저런 얘기

991 개 검색됨 : 기술,IT 에 대한 결과

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

중국 전통의상중 하나. 한푸라는 단어를 사용하긴 하지만, 오래전부터 사용하던 단어는 아닌걸로 알고 있다. 치파오는 중국 만주족의 전통복식이기 때문에 이건 확실하게 중국 전통의상 이라고 할 수 있는데, 한푸라고 올라오는 AI가 생성한 의상들은 이게 중국 의상인지 혼동될때가 많다.

보통 중극 무협 드라마에서 배우들이 입은 의상이 한푸라고 하지만, 이건 송, 명, 고려의 의상을 혼합한 형식이 많으니 말이다. 특히 동아시아 복식은 송, 명, 만주 및 고려, 조선의 영향을 주거니 받거니 해서 서로 닮아있긴 하다.

미니 드레스로 생성했다. 치파오는 원래는 옆트임이 강한 긴 드레스다. 치파오 입고 말을 타야했으니 옆트임을 강하게 할 수 밖에 없다. 단 속에는 바지를 입었기 때문에 노출이 많은 의상은 아니었다.

치파오는 여인의 매력을 잘 어필할 수 있는 매력적인 의상이다. 여태까지 AI로 잘 생성하지 못하다가 괜찮은 LoRA 가 올라와 생성해 봤다.

주로 붉은색 치파오를 많이 입었지만, 파란색도 꽤 있었다고 한다. 노란색 의상은 AI 그 그렇게 생성했고 예쁘길래 그냥 넣어봤다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

미녀 다섯번째 포스트.

두개의 LoRA 와 자체 머지한 체크포인트를 사용해 만든 미녀. 기존과는 다른느낌을 주려고 노력했고, 결과적으로 턱을 조금 깎았다. 다른건 최대한 비슷하게 했다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

Stable Diffusion - 빅토리아 의상 #1

CivitAI 에 빅토리아시대의 의상 LoRA 가 올라왔는데, 이걸 사용해서 생성했다. 동일하게 생성한건 아니고 내 식대로 변형을 가했다. 꽤 잘 나와서 올려본다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

배경으로 화염을 그려주는 LoRA 를 사용했다. 하지만, 의도와는 조금 달라졌는데, LoRA 샘플에는 멋졌지만, 이건 어딘가 불을 지른 느낌의 화염이다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

Stable Diffusion - 그리움 戀

우연히 음악 듣다가 "그리움"을 주제로 그릴 수 있지 않을까 하는 생각에 생성한 그림. 1100 여 장에서 31장 발췌했는데, 만족할만한 수준이 나와 올린다.그리움, 달빛, 바다, 은하수, 소녀가 키워드다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

달빛, 바다, 은하수를 주제로 생성한 사진은 아니고... 1girl 프롬프트가 적용되질 않았다. 1100여장중에 2장이 그렇다. 하지만, 맘에 들어 올려본다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

프롬프트 전면 교체까지는 아니어도 지난 번보다 많이 교체했다. LoRA 를 두개써서 만들었다. 나름 만족하게 되었다. 앞으로 이걸 기반으로 만들 생각.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

드레스 중에 롱 트레인(Long Train) 타입이 있다. 오랜 옛날에는 매우 예를 갖추어야 할 예식에 입는 옷이었다. 대관식이라던가 말이다. 요즘엔 입는 경우는 못봤고, 가끔 웨딩 드레스 중에 이런 롱 트레인 타입의 드레스가 있긴하다. 하지만 그걸 입는건 못 봤다. 롱 트레인 드레스를 쉽게 말하면 드레스 뒷자락을 매우 길게 늘여 만든 드레스다.

하지만 AI 로는 생성하기 어렵다. 트레인 이란 단어가 들어가기 때문에, 생성한 이미지에 기차가 나오기 때문이다. 현실에서 보기 어려운 드레스를 생성해내는게 내 목표이기도 하기 때문에 몇번 도전해봤는데 잘 안되었다. 하지만 오랜 시도끝에 드디어 되었다. 비슷한 LoRA 가 있길래 몇일 시행착오끝에 나온거다. 뭔가 오래묵은 과제 하나 해결한 후련한 느낌.

- 글쓴시간

- 분류 기술,IT/하드웨어 정보

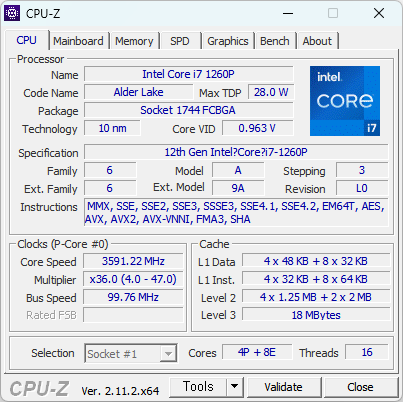

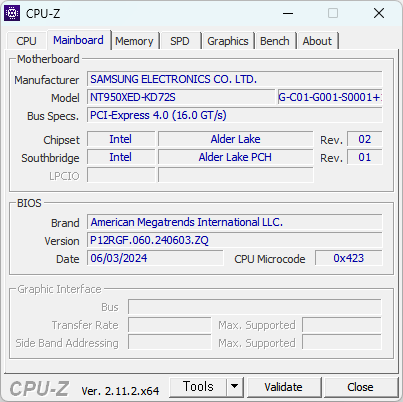

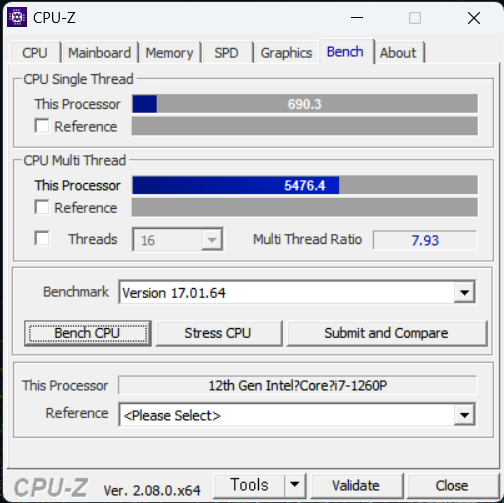

i7-1260P 는 이번에 교체한 노트북에 장착된 CPU다. 12세대 CPU로 골랐다. 현 시점에서 13세대 CPU를 사용하려면 메모리를 줄여야 한다. 13세대나 12세대나 성능이 그게 그거기도 하고 차라리 한세대 낮춰서 메모리를 올리는게 성능이 더 좋을거란 생각에 12세대 선택했다.

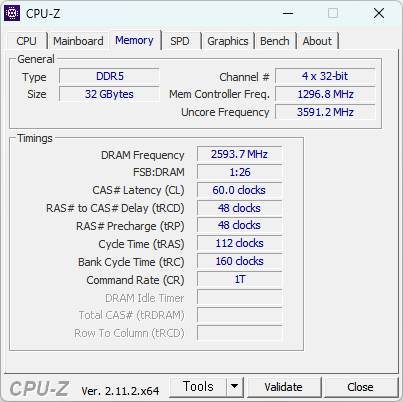

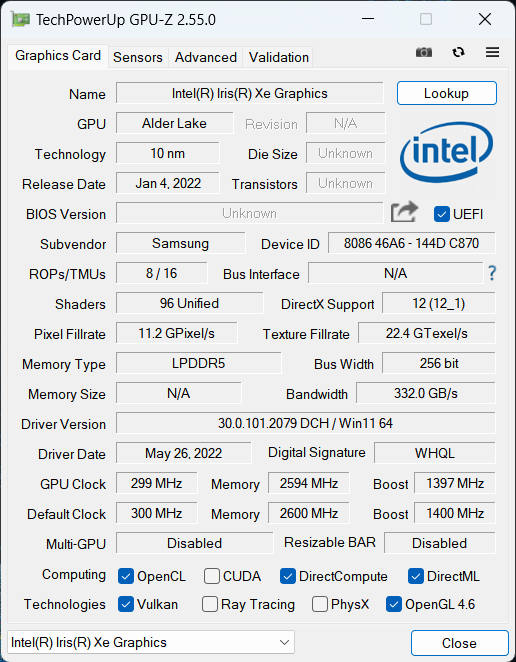

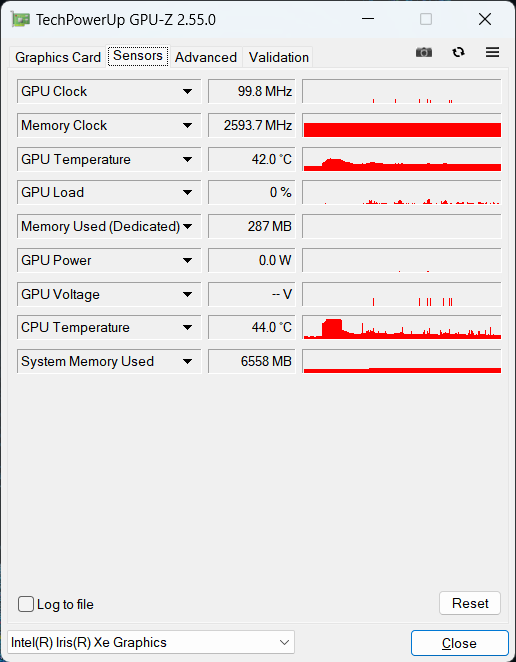

DDR5-5200 으로 작동 중이다.

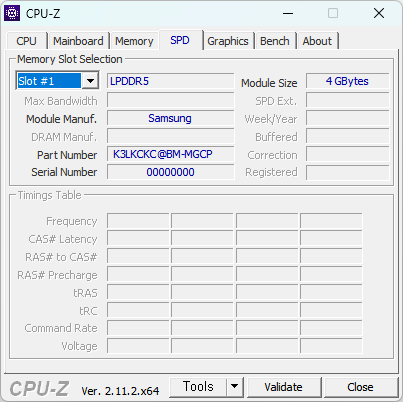

메모리가 상당히 특이하게 달려있는거 같다. 일단 DIMM 형식은 아닌듯.

16코어 많아보이긴 하지만, 체감 성능은 어차피 거기서 거기다. 이번에 나온 14세대도 마찬가지이기도 하고 말이다.

그래도 싱글 속도가 690점대인건 상당히 의외다. 물론 발열때문에 바로 낮아지긴 하지만 말이다.

내장 그래픽 코어도 나름 준수하다고 생각한다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

Stable Diffusion 에서 잘 못 만드는 의상 중 하나가 볼 가운(Ball Gown) 드레스다. AI가 드레스는 잘 만드는데 몸에 착 달라붙는 의상으로 생성하곤 한다. 이 의상에 풍성함을 주기 위해 프롬프트를 조절해 봐도 잘 안된다.

볼 가운 드레스는, 볼 드레스(Ball Dress), 볼 룸 드레스(Ball Room Dress), 댄스 드레스(Dance Dress)라고도 부른다. "볼 룸"을 번역하면 무도회장이다. 즉 무도회용 드레스다. ball 은 "춤을추다"라는 의미인 고대 프랑스어 baller 에서 유래되었다. 비슷한 유래를 가진 말로 발레 ballet 가 있다.

아래와 같이 어쩌다 한번 제대로 된 볼 가운 드레스가 생성되는 경우는 있다. 그걸 올려본다. 1000장은 생성해본거 같은데 쓸만한건 1장 나왔다. 그래도 마음에 들게 나와서 다행.