윈디하나의 블로그

윈디하나의 누리사랑방. 이런 저런 얘기

2442 개 검색됨 : 분류 전체보기 에 대한 결과

- 글쓴시간

- 분류 문화,취미

딥 시크 R1 을 Python vLLM 을 사용해 로컬에서 실행해 보았다. DeepSeek-R1-Distill-Qwen-1.5B 모델을 사용했는데, 이 모델은 DeepSeek R1 에서 Distill 된 모델중 가장 작은 모델로, 수학 모델이다. 한글을 잘 인식하질 못해서 영어로 질문했다. 인터넷에서 영문 수학 문제를 검색해 문의해보았다.

인터넷을 찾아보면 한글 지원하는 모델도 쉽게 구할 수 있고, 7B 모델만 되어도 한글 잘 인식한다고 한다. 하지만 필자의 사양에서는 못 돌린다. 그래서 INT8 으로 양자화된 모델을 찾고 있기도 하다.

서버 사양은 Ubuntu 22.04, i7-7700K, 32GB, RTX 2060 12G 이다. 아래와 같이 실행했다.

$ mkdir DeepSeek-R1-Distill-Qwen-1.5B

$ cd DeepSeek-R1-Distill-Qwen-1.5B

$ python3 -m venv venv

$ . venv/bin/activate

(venv) $ pip install vllm

(venv) $ vi run.py

from vllm import LLM, SamplingParams

llm = LLM(

model="deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B",

dtype="half",

max_model_len=8_000

)

sampling_params = SamplingParams(

temperature=0.5,

max_tokens=8_000

)

prompts = [

"""The day before yesterday I was 25. The next year I will be 28. This is true only one day in a year. What day is my Birthday?"""

]

conversations = [

[{"role": "user", "content": x}] for x in prompts

]

outputs = llm.chat(conversations, sampling_params=sampling_params)

for output in outputs:

print(output.outputs[0].text)

(venv) $ python run.py

실행 결과는 아래와 같다. 보기좋게 편집되어있다. 질문은 생일을 맞추는 문제인데, "2일 전에는 25살, 내년에는 28살"일 때 생일을 묻는 문제로, 생일은 12월 31일이다. 정확하게 맞췄다. 약 25초 정도 걸렸다. VRAM 사용량은 약 9.5GB 정도 된다. (nvidia-smi 으로 측정)

(venv) $ python run.py

INFO 02-00 18:51:00 __init__.py:183] Automatically detected platform cuda.

WARNING 02-00 18:51:02 config.py:2368] Casting torch.bfloat16 to torch.float16.

INFO 02-00 18:51:07 config.py:526] This model supports multiple tasks: ...

INFO 02-00 18:51:07 llm_engine.py:232] Initializing a V0 LLM engine (v0.7.1) ...

INFO 02-00 18:51:08 cuda.py:184] Cannot use FlashAttention-2 backend for Volta and Turing GPUs.

INFO 02-00 18:51:08 cuda.py:232] Using XFormers backend.

INFO 02-00 18:51:09 model_runner.py:1111] Starting to load model

deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B...

INFO 02-00 18:51:09 weight_utils.py:251] Using model weights format ['*.safetensors']

INFO 02-00 18:51:10 weight_utils.py:296] No model.safetensors.index.json found in remote.

Loading safetensors checkpoint shards: 0% Completed | 0/1 [00:00<?, ?it/s]

Loading safetensors checkpoint shards: 100% Completed | 1/1 [00:00<00:00, 1.06it/s]

Loading safetensors checkpoint shards: 100% Completed | 1/1 [00:00<00:00, 1.06it/s]

INFO 02-00 18:51:11 model_runner.py:1116] Loading model weights took 3.3460 GB

INFO 02-00 18:51:12 worker.py:266] Memory profiling takes 1.05 seconds

INFO 02-00 18:51:12 worker.py:266] the current vLLM instance can use

total_gpu_memory (11.55GiB) x gpu_memory_utilization (0.90) = 10.40GiB

INFO 02-00 18:51:12 worker.py:266] model weights take 3.35GiB;

non_torch_memory takes 0.04GiB; PyTorch activation peak memory takes 1.41GiB;

the rest of the memory reserved for KV Cache is 5.60GiB.

INFO 02-00 18:51:12 executor_base.py:108] # CUDA blocks: 13097, # CPU blocks: 9362

INFO 02-00 18:51:12 executor_base.py:113] Maximum concurrency for 8000 tokens per request: 26.19x

INFO 02-00 18:51:14 model_runner.py:1435] Capturing cudagraphs for decoding.

This may lead to unexpected consequences if the model is not static.

To run the model in eager mode, set 'enforce_eager=True' or use '--enforce-eager' in the CLI.

If out-of-memory error occurs during cudagraph capture,

consider decreasing `gpu_memory_utilization` or switching to eager mode.

You can also reduce the `max_num_seqs` as needed to decrease memory usage.

Capturing CUDA graph shapes: 100%|█████████████| 35/35 [00:09<00:00, 3.63it/s]

INFO 02-00 18:51:24 model_runner.py:1563] Graph capturing finished in 10 secs, took 0.19 GiB

INFO 02-00 18:51:24 llm_engine.py:429] init engine (profile, create kv cache, warmup model)

took 13.48 seconds

INFO 02-00 18:51:24 chat_utils.py:330] Detected the chat template content format to be 'string'.

You can set `--chat-template-content-format` to override this.

Processed prompts: 100%|███████████████████████

[00:04<00:00, 4.14s/it, est. speed input: 9.66 toks/s, output: 81.16 toks/s]

<think>

To determine the day of the birthday, I start by analyzing the information given.

First, it's stated that the day before yesterday, the person was 25.

This means that yesterday was the birthday day, and today is the day after birthday.

Next, it's mentioned that the next year, the person will be 28.

This implies that the current age is 25 plus 1, which is 26.

Since the person will be 28 in the next year, their birthday must be on December 31st.

This is because the next year's birthday will occur on the same date,

and the age will increase by one year.

Therefore, the birthday is December 31st.

</think>

To determine the day of your birthday, let's analyze the information step by step:

1. **Day Before Yesterday:**

- You were **25** years old the day before yesterday.

- This means **yesterday** was your birthday day.

2. **Next Year:**

- You will be **28** years old in the next year.

- If you are currently 26 years old, your birthday will be on **December 31st** because:

- **Today** is **December 31st**.

- **Tomorrow** will be **January 1st**, and you'll turn **27**.

- **Next Year** (two years from now) you'll be **28** years old.

**Conclusion:**

Your birthday is on **\boxed{December 31st}**.

Think 태그에 보면 사고의 흐름을 볼 수 있다. 이런게 나오긴 한다 정도로 생각하면 된다. 정답은 맞췄지만 논리적 사고를 한다기 보다는 문장의 흐름, 패턴을 검색해 유추한다고 생각한다.

- 글쓴시간

- 분류 기술,IT/하드웨어 정보

2008년 5월경 구매한 기가비트 8포트 스위치. 굉장히 오래된 제품이지만 아직까지도 가지고 있다. 잘 작동하기도 하고 말이다.

※ 스펙

칩셋: BCM5398, MNC G4802CG, MNC G4802SG

표준: 10BASE-T/100BASE-TX/1000BASE -T

포트: 10/100/1,000Mbps 8포트, Auto MDI/MDIX

전송방식: Fast store-and-foward

MAC 테이블/학습방법: 8k / 자Self-learning, Auto-Aging

패킷필터링/포워딩: 포트당 14880/148800/1488000pps

전원: DC 9V, 1.2A

크기: 105(W) x 80(D) x 26(H)mm

출시가격: 4.6 만원

케이스가 철제 프레임으로 되어있어서 방열에 좋은 편이다. 생각보다는 작은 크기다.

번들해주는 어댑터가 리니어 방식이라 크고 무겁다. (그만큼 리니어 방식 어댑터가 비싸다. 저렴한게 아니라서 좋다)

- 글쓴시간

- 분류 기술,IT

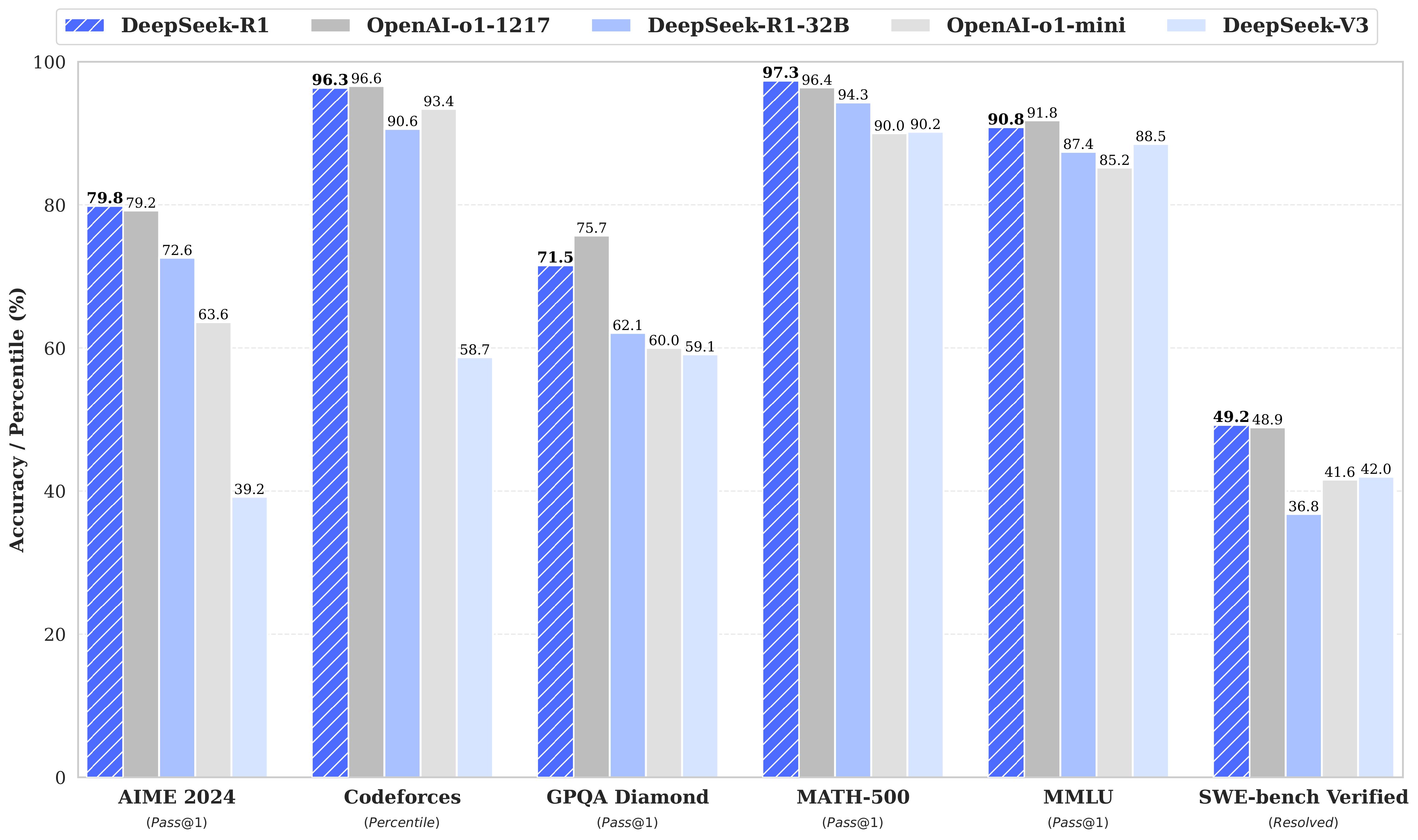

DeepSeek R1는 중국의 DeepSeek 에서 개발한 LLM 모델입니다. 쉽게 말하면 ChatGPT 같이 사용할 수 있는 AI 라고 생각하면 됩니다. 요즘에 주목받는 AI인데요, 그 이유중 하나가 성능이 좋고 무었보다 오픈소스이기 때문입니다.

성능이 좋다는건 사용자가 원하는 답을 잘 내어준다는 의미입니다. 들리는 말에 의하면 OpenAI 의 ChatGPT o1 보다 더 좋다는 말이 있네요.

DeepSeek R1 벤치마크.

하지만 저에게 무었보다 좋은건 오픈소스라는 점 때문입니다. 이정도 성능의 모델을 오픈 소스로 풀 거라고는 생각 못했습니다. 오픈 소스로 풀린다고 해서, 당장 제가 가진 PC에서 돌려보거나 할 수는 없겠습니다만, 일단 오픈소스라는게 가장 좋아보이네요. 몇몇 사용기가 올라온걸 보면 꽤 괜찮다는것 같습니다. AI 에서 중요한 것 중 하나가 개방성인데, 거대 LLM 을 오픈하는건 중국이 미국보다 먼저 했네요.

비용이 많이 들어가는 RLHF(Reinforcement Learning from Human Feedback, 인간의 피드백에 의한 강화 학습), SFT(Supervisor Fine Tuning, 감독자에 의한 파인 튜닝)을 사용하지 않고, RL(Reinforcement Learning, 강화 학습) 만을 사용했다고 합니다. 그래서 비용이 줄었다고 하네요. 이게 대단한게 RL 만으로는 한계가 있어서 RLHF, SFT 를 사용했던건데, 다시 RL 만으로도 된다는걸 보여주는 거라고 합니다. 물론 RL 만으로 학습한게 티가 난다고 합니다만, 어느 정도일지는 사용자마다 다르겠죠. 어쨋던 대단하긴 합니다.

또한 MOE(Mixture of Experts, 전문가 혼합) 기법을 사용해 특정 주제에 맞는 부분만 활성화 시켜 연산시키기 때문에 훈련과 추론시 사용하는 메모리를 줄였고, MLA(Multi-head Latent Attention) 를 사용해 키-값을 처리해 메모리를 더 줄였습니다. 마지막으로 nVidia CUDA에서 사용하는 PTX(Parallel Thread xecution)를 적극적으로 사용해서 성능을 향상시켰습니다. PTX 는 일종의 하드웨어 독립적인 언어로, CUDA 보다도 더 저수준의 언어입니다. PTX 는 일종의 GPU용 어셈블러이긴 하지만 하드웨어 독립적입니다. (하드웨어 독립적이긴 하지만 nVidia 제품에만 사용됩니다. nVidia GPU 아키텍처에 독립적이라는 의미입니다. CUDA/PTX 를 사사용해 작성한 코드는 바이너리 코드로 변환되어 실행되는데 이 바이너리 코드를 SASS(Source and Assembly)라고 부릅니다. SASS 가 GPU에 의존적입니다) PTX 를 사용한다는게 굉장히 어려운 일이기 때문에 CUDA 정도만 사용했었는데, 중국에서는 이걸 했나보네요.

또한, 아직 추정이긴 합니다만, Distilled(추출기법)도 사용했을거라고도 생각합니다. 학습된 모델의 추론 결과를 학습할 모델의 입력으로 사용하는걸 말합니다. 쉽게 말하면 ChatGPT 의 결과를 DeepSeek 의 입력으로 사용했다는 겁니다. (이런 방식은 ChatGPT 이용 약관 위반입니다) 기사를 보면 OpenAI 에서는 어느 정도 증거를 가지고 있는것 같이 보입니다.

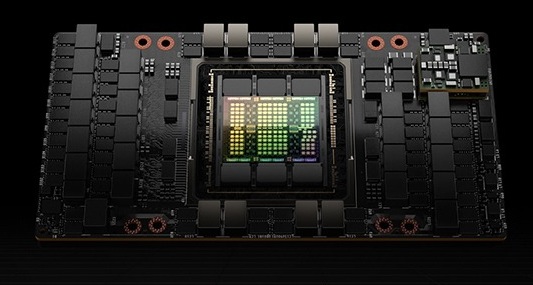

중국에 대한 수출 제한으로 nVidia H100 을 사용하지 못하는 제약때문에 nVidia H800 (H100 의 중국 수출 판)을 사용할 수 밖에 없었는데, H800 이 가진 한계(칩 간 전송 데이터 폭이 H100 의 절반, FP64 성능은 많이 떨어지나 FP32, TP32, BF16, FP16 의 연산은 성능이 동일함)를 극복한걸로 보이네요. H800 이 H100 에 비해 그렇게 떨어지는것도 아니긴 하구요.

nVidia H100

사용하는 방법에는 여러가지가 있겠습니다만 제가 본건 nVidia 에서 배포한 TensorRT-LLM - Deepseek-v3 사용 방법입니다. 여기에서는 BF16을 사용할 걸 추천하는데, 이경우 GPU 메모리가 1.3TB 이상 되어야 합니다. 모델 파일만 650GB 정도 되어보이고 모델 파일은 FP8 으로 되어있는것 같네요. 게다가 현재는 Hopper 아키텍처에서만 작동한다고 합니다

생성형 AI 를 사용하는 때에도, 중국 아니면 일본, 미국에서 만든 LoRA 가 많이 올라옵니다. 중국이 특히 많구요, 우리나라도 제법 있긴 합니다만, 다수라고 보기엔 무리가 있습니다. 그나마 오노마에이아이 (Onoma.AI) 에서 만든 Illustrious XL(ILXL) 과, ILXL 기반으로 만든 NoobAI-XL 이 생성형 AI 에서는 제법 알아준다고나 할까요. 우리나라도 어서 LLM 이 공개되었으면 하네요. 누가 공개할지는 모르겠습니다만 말이죠.

로컬에서 실행하는 방법: DeepSeek R1 로컬에서 실행

- 글쓴시간

- 분류 기술,IT

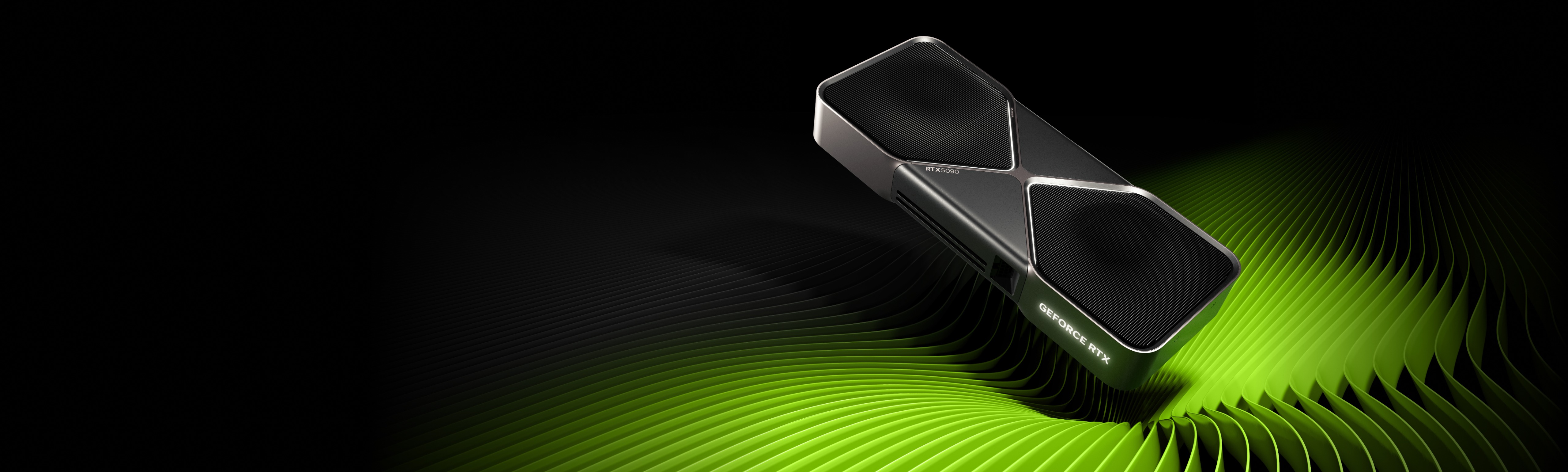

이번 CES 에서 nVidia 가 GeForce 50 시리즈를 발표했습니다. 코드명 블랙웰입니다. 우선 GeForce RTX 5080 이 먼저 나오고 이후에 다른 GPU 들도 순차적으로 나올 예정입니다.

- 가장 눈에 띄이는건 DLSS4 와 DLAA Multi Frame Generation 라는 신기술의 도입입니다. 응답속도를 줄이고, 프레임 보간을 4배로 해줍니다. 게임에서 초당 프레임이 60 fps 이 나온다면 DLSS4 와 Multi Frame Generation 를 사용해서 240 fps 까지 프레임 레이트를 올릴 수 있다는 거죠.

- 가격은 5090만 400달러 올라 1999 달러이고, 다른 제품은 동결입니다.

- 이번 부터 FP6 과 FP4 를 지원합니다.

- DLSS를 사용하지 않은 성능은 기존 동급의 기기와 거의 비슷할 거라고 합니다. 일단 스펙이 같고, 일부 스펙은 오히려 줄었습니다. 캐시가 늘긴 했지만 근본적으로 바뀐게 아니기 때문에 성능은 큰 향상은 없을걸로 생각합니다. 하지만 DLSS4 와 향상된 DLAA 를 게임에서 사용하면, 5070 은 4090 급의 성능을 내어줄거라고 하네요.

- 메모리는 조금 아쉽네요. 5090 에만 32GB 를 넣어주었습니다. 4090 은 24GB 이었으니 늘긴 했지만 다른 제품군에서는 전혀 늘지 않았네요. 이부분은 조금 아쉽습니다. 그래도 5090 에 32GB 를 넣어주는 바람에, RTX 5000 Ada Generation 의 가격이 떨어질걸로 예상합니다. 5090이 32GB 으로 나오면 이걸 살꺼라서요. 반대로 메모리를 많이 넣어주면 게임용이 아니라 AI용이 되기 때문에 가격이 오릅니다. 모 국가에서 대량으로 구매할거라서요. 여태까지 그래왔죠. 소비자가 실제 구매할 수 있는 가격이 어떻게 될지는 두고봐야할거 같네요.

지금 4060Ti 16GB 를 쓰고 있고 이후에는 24GB 아니면 32GB 메모리를 써야 한다고 생각하지만, 5090은 너무 비싸서 못 삽니다. 조금 기다리는거 외에는 방법이 없네요. 한 6개월 후, 그러니까 올 가을 쯤에는 5060을 볼 수 있으려나요.

- 글쓴시간

- 분류 기술,IT/하드웨어 정보

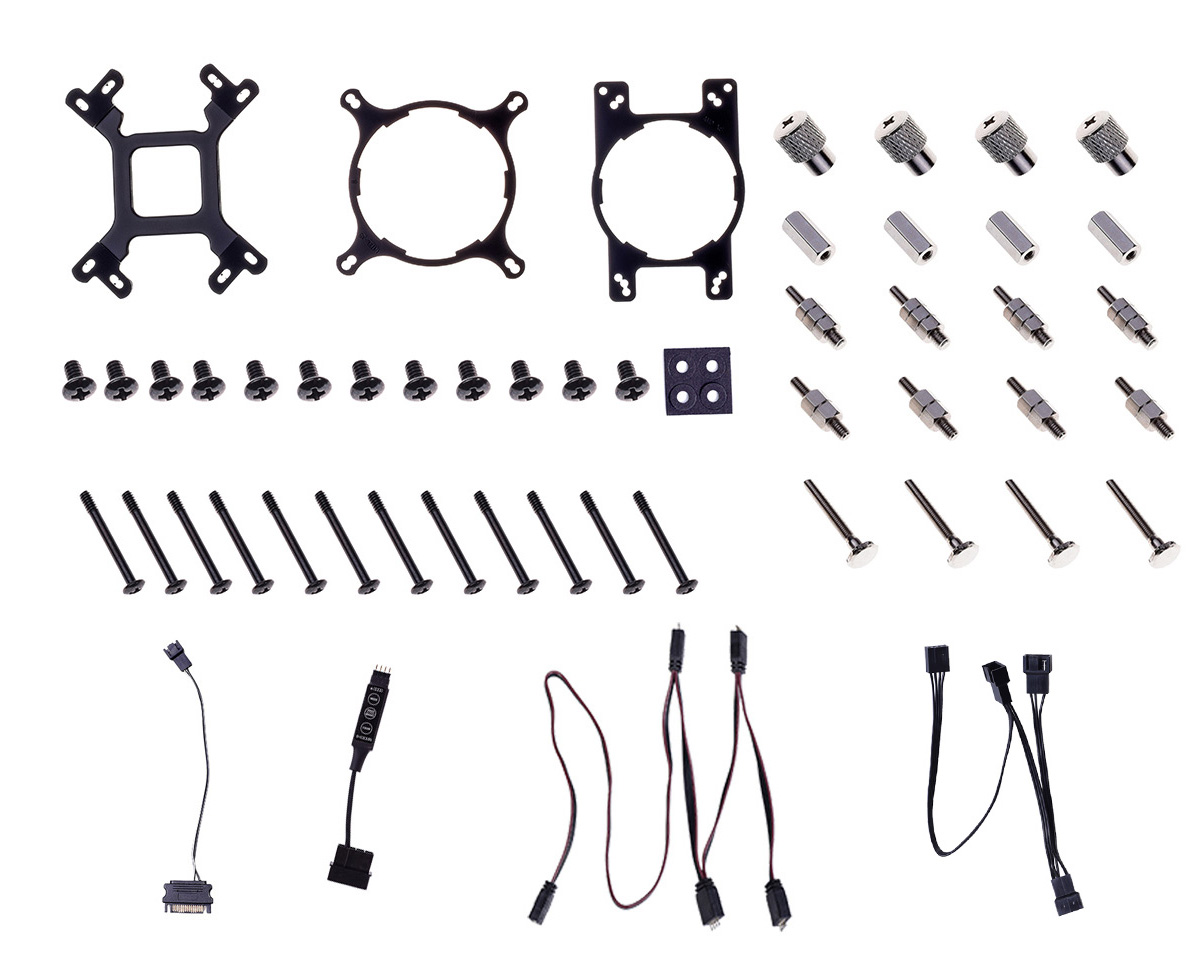

당근에서 저렴하게 팔길래 구매한 수랭 쿨러. 3열 수랭이다. 2019년 3월에 출시했다. 출시가는 12만원 중반대.

5년이 넘은 제품이라 쿨링이 잘 안될것 같기도 했는데, 역시나, 일단 받아보고 쿨러를 재조립했다. 뭔가 막혀있었던 셈. 이후에는 문제 없이 사용중이다.

쿨러가 상당히 좋은 거다. 12V RGB 도 지원한다. (ARGB 가 아니다)

3열이라 기존에 사용하던 1열 수냉 쿨러보다 CPU 온도가 떨어질 줄 알았는데 그건 아니다. 그냥 팬이 더 천천히 돌기 때문에 조용한 정도. 하지만 팬도 5년전의 팬이라 요즘 나오는 고성능 팬에 못 미치는 성능이다. 그래도, 구매 가격 생각하면 매우 만족하면서 쓰고 있다. 처음엔 RGB 팬 3개만 얻어도 본전이라고 생각한 가격이었으니 말이다.

스펙

Compatibility Intel LGA2066/2011/1700/1200/1151/1150/1155/1156

AMD AM5/AM4

TDP 350W

Radiator Dimension 397×120×27mm

Radiator Material Aluminum

Tube Material Premium Sleeved Tubing

Tube Length 465mm

Waterblock Dimension 72x72x47.3mm

Cold Plate Material Copper

Pump Current 0.36A

Rated Voltage 12V DC

Current 0.36A

Rated Power 4.32W

Pump Lift Range 1.3m H2O

Maximun Waterflow 106L/H

Pump Speed 2100±10%RPM

Pump Bearing Ceramic Bearing

Pump Life Expectancy 50,000 Hrs

Pump Noise Level 25dB(A)

Fan Dimension 120×120×25mm

Fan Speed 700~1800±10%RPM

Max. Air Flow 74.5CFM

Max. Static Pressure 2.15mmH2O

Noise 18 ~ 35.2dB(A)

Rated Voltage 12VDC

Operating Voltage 10.8~13.2VDC

Started Voltage 7VDC

Rated Current 0.2A

Power Input 2.4W

Bearing Type Hydraulic Bearing

Connector 4Pin PWM / 12V 4Pin RGB

https://prod.danawa.com/info/?pcode=7494676

https://www.idcooling.com/product/detail?id=153&name=AURAFLOW%20X%20360

----

2025.04.19

CPU 부하시 온도가 80도를 넘어 다시 한번 펌프 부위를 분해해봤다. 역시나 끈적해보이는 젤리같은게 (실제로 끈적하지는 않다) 잔뜩 끼어있었다. 이물질들을 제거하고 다시 조립하니 CPU 부하시에도 온도가 60도 정도로 정상상태로 되었다. 지난 1월 초에 했을때 이물질을 다 제거하지 않았긴 한데, 그래도 생각보다는 많았다. 올 여름은 이거로 지내고 가을 무렵에 다시 한번 열어봐야겠다.

----

2025.05.24

온도가 높아져 다시 분해해 봤다. 끈적이지는 않지만 뭔가 딱딱한 부스러기 같은게 끼어 있었다. 펌프를 막지는 않은것 같지만, 그래도 CPU 온도가 높아진거기 때문에 모두 제거했다. 펌프도 꽤 뜨거웠기 때문에 조금 기다려서 식힌다음에 분해했다.

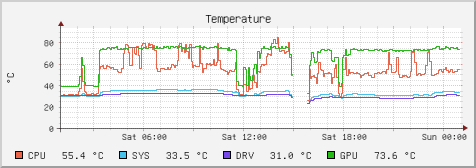

온도 그래프를 보면, 15시쯤에 수리를 시작했고 약 한시간 정도 걸렸다. 빨간색이 CPU 온도인데 평균온도가 80을 넘으면 실제 코어 온도는 100도가 넘는다는 거고 이렇게 되면 쓰로틀링이 걸린다. 수리후에는 온도가 60도 이하로 내려갔다. 수리 전보다 훨씬 더 낮아진 느낌.

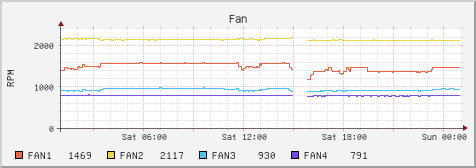

같은시점의 팬 RPM 그래프다. 특이사항 없다.

ID-COOLING ICEKIMO 120

- 글쓴시간

- 분류 이야기

올해에는 해돋이를 보러 가지는 못하고 해서, 그림으로 대신한다. 2024년 만큼 우리나라에 다사다난했던 해도 없었던것 같다. 하지만 2025년에는 이 모든게 잘 해결되리라고 믿는다.

해를 바라보기만 하기 보다는 해를 향해 다가가는 모습이 더 어울는 한해가 되길.

- 글쓴시간

- 분류 시사,사회

2024년 12월 29일 09시 03분(KST) 발생한 제주항공 2216편 활주로 이탈사고. 이로 인해 탑승인원 181명중 승무원 2명을 제외한 나머지 179명이 사망한 사고다. 무안공항에서 발생했다.

처음엔 주로 가는 커뮤니티 사이트에 "사고 영상"이라는 제목의 동영상을 본걸로 시작했다. 영상속의 비행기가 동체착륙하길래 동체착륙 잘 했네, 감속 안되네 라고 생각하고 있는 찰나, 영상은 비행기가 활주로 끝을 지나며 바로 벽에 부딪히며 끝났다. 영상을 보고 난 후 큰일이다 싶었고, 저기에 왜 벽이 있는건지에 대한 의문이 들긴했다. 이후에 이게 오늘 아침에 일어난 일이라는걸 알게 되었다.

원인은 버드 스트라이크로 인한 엔진 고장으로 추정. 하지만 필자의 생각엔 동체착륙을 잘 했음에도 불구하고 사망자가 많이 나온건 활주로 끝을 지나 너무 가까이에 있었던 콘크리트 벽 때문이라고 생각한다. 물론 이글을 쓰는 시점에서는 아직 조사중이기 때문에 최종 결론이 나오면 다시 이 글을 수정할 예정이다.

어쨌든 지금은 사고 원인 규명보다는 사고 수습이 먼저다.

----

2025.07.22

한쪽 엔진은 멀쩡했다고 하는데 현재 조종사가 멀쩡한 엔진을 껐다는 이야기가 나오고 있다. 반대로 말하면 다른 한쪽은 정상적이지 않았고 그래서 동체착륙을 잘 했다는 의미인거 같다.

예전에 어느 커뮤니티에서 읽었던 글이 다시 떠오른다.

- 사고의 원인은 버드 스트라이크로 추정되는 엔진 고장이지만

- 참사의 원인은 활주로 끝에 있는 콘크리트 벽 때문이다.

라고 말이다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

우연히 그린 복장. 마음에 들었다. 무슨 복장이라고 해야할지는 모르겠다.

- 글쓴시간

- 분류 시사,사회

민주주의 최후의 보루는 깨어있는 시민의 조직된 힘입니다.

노무현 대통령이 축사영상에서 이야기한 말입니다. 요즘에 가장 와 닿는 말이네요.

계엄이 일어났다가 해제되었지만 아직까지도 후폭풍은 가라앉지 않고 있습니다. 경제적으로는 최소 300조, 최대 900조 정도의 손실을 예상하고, 이 손실은 우리 오천만 국민들이 할부로 갚아나가야 할거라고 합니다. 에혀... 중국의 거센 추격을 떨쳐내기도 힘든데 이런 것까지 신경써야 할건지 모르겠네요.

그리고 한가지 더 이야기 하고 싶습니다. 저는 쿠데타 실패의 가장 큰 원인이 바로 "교육"이라고 생각합니다. 요즘에는 학교에서 5.18 이나 12.12 에 대해 배우고, 당시의 참상에 대해 배우고 있습니다. 군인은 국민을 향해 총을 겨누면 안된다는 걸 배우죠. 제가 중/고등학생 때에는 배우지 않은 내용입니다. 그리고 권력은 국민에게서 나오고 영원한 권력은 없다, 독재는 없다는 걸 알려주죠. 5.18을 일으킨 주범은 결국 사형을 선고 받은것도 알고 있습니다. 즉 군인이라 해도 불법적인 명령에 따를필요 없다는걸 알고 있고, 무었이 불법적인것인지 정확히 이해하고 있습니다. 오직 그들만이 젊은 군인들이 그 명령에 따를리가 없다는걸 이해하지 못한거 같네요.