- 글쓴시간

- 분류 기술,IT

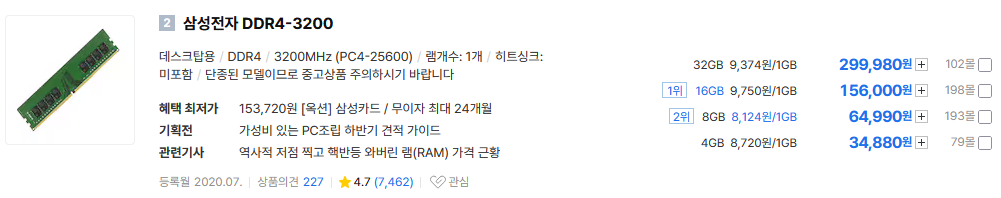

오랜만에 다나와 가서 메모리 가격을 살펴보고 있었는데, DDR4 가격이 그야말로 급 상승해버렸다. 32GB 에 19.9 만원. 메모리 가격이 오른다는건 알고 있었지만 이미 구시대의 메모리인데다 단종까지 된 제품인데 아직까지 수요가 있나보다.

기존 가격은 7 ~ 10만원으로 8만원 정도로 기억한다. 이 가격이 몇년동안 계속되었기 때문에 이 가격에서 단종 수순으로 갈걸로 생각했다.

원래 메모리 단종 직전엔 판매점 개수가 떨어지면서, 가격이 오르지만, 이번에는 판매점 수는 그대로다. 즉 재고가 있는 상황에서도 가격이 오른 셈이다. 메모리 재고가 소진되면 아예 안 팔 테니 사재기 하는 수요가 있다고는 들었지만 이정도라고는 생각하지 못했다.

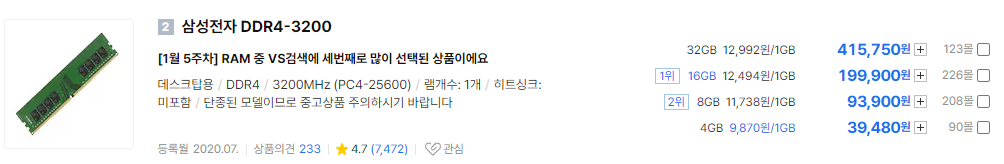

2025.10.26 DDR4 메모리 가격 - 20만원

DDR5 에서는 그저 그렇지만, DDR4 는 삼성 제품만한게 없다. 삼성 제품의 2025.10.26 일자 가격 올려본다. 실제로 구매할 수 있는 가격은 위 가격에서 10% 정도 더 쳐줘야 한다. 32GB DDR4 메모리가 약 20만원이라는건 말 그대로 (일반인들은 살 수 없는) 최저가일 뿐이다.

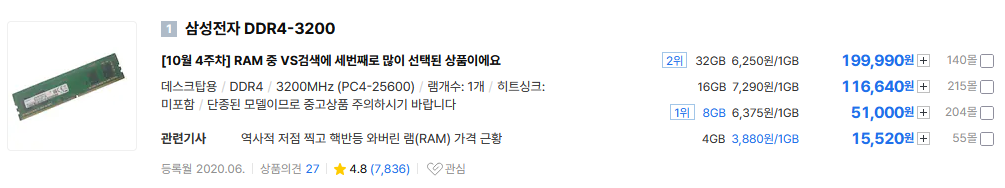

요즘 이거 보면 뿌듯하다. 내가지금 100만원대 시스템을 사용하고 있는거니 말이다. (메모리 가격 오르기 전에는 40만원대)

적당한 시점에서 DDR5 으로 넘어가려 하는데 DDR5 가격도 만만하지 않아 고민이긴 하다.

재작년 12월부터 DDR4 메모리를 중고로 샀었다. 중고로 16GB 3만원, 32GB 6만원 안팍에 구매했는데, 이렇게라도 사 놓은게 다행이겠거니 하고 있다. 더 구매해야 하는데 지금은 너무 비싸져서 못 사고 있다. 중고가격도 예전에 매입가 생각나기 때문에 못 구매하겠다. 문제라면, 내년엔 더 오를 전망이라는 거다.

2023.12 Samsung DDR4 16G DDR4-2666V PC4-21300 x 2 구매

2024.04 Samsung DDR4 16G DDR4-2666V PC4-21300 x 2 구매

2024.08 Samsung DDR4 32G DDR4-3200AA PC4-25600 x 2 구매

2025.04 Samsung DDR4 32G DDR4-3200AA PC4-25600 x 4 구매

----

2025.11.08

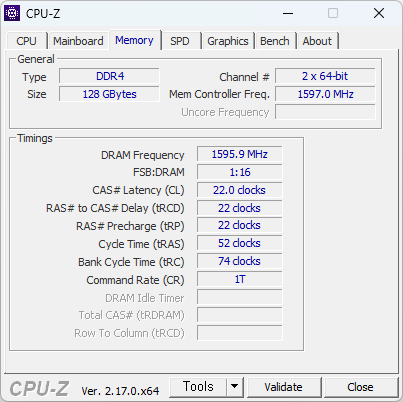

더 올랐다. 32GB 24.7 만원. 오르는 속도가 솔찍히 무서울 정도. PC 구매를 포기해야할 수도 있겠다.

2025.11.08 DDR4 메모리 가격 - 25만원

----

2025.12.21

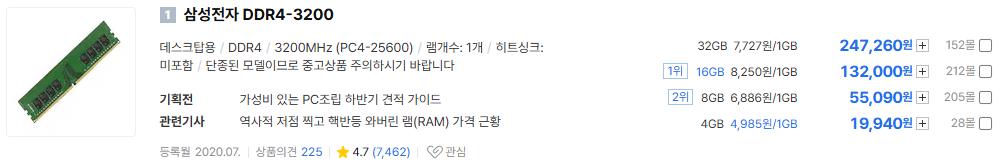

30만원. 2026년 상반기까지는 오를게 확실하고, 하반기까지도 유지될꺼라고 한다. DDR6 나올때쯤에나 정상화 될거라는 전망도 있다.

2025.12.21 DDR4 메모리 가격 - 30만원

이제 필자는 140만원대 PC 를 사용하고 있는 셈이다. 에혀.

----

2026.01.29

DDR4 32GB 40만원. 에혀. 3개월만에 신품 가격이 2배 올랐다. 지금은 DDR4 32GB 중고가격도 25 만원 정도로, 3개월 만에 3배 올랐다. 그나마 이것도 물량이 없다.