윈디하나의 블로그

윈디하나의 누리사랑방. 이런 저런 얘기

2445 개 검색됨 : 윈디하나 에 대한 결과

- 글쓴시간

- 분류 기술,IT

금번 윈도 11 24H2 업데이트부터, 커널에서 POPCNT, SSE4.2 명령셋을 필수로 사용하도록 변경되었습니다. 따라서 이 명령셋들을 지원하지 않는 Core 2 CPU는 윈도 11 23H2 운영체제까지만 사용 가능합니다. 아직 Core 2 CPU를 사용한 PC를 가지고 있는 저로써는 좀 아쉽습니다만, POPCNT 명령셋이 필요한건 맞고, Core2 가 2006년에 출시되었을 정도로 오래된 CPU 이니 어쩔 수 없다고는 생각합니다.

※ POPCNT

2020년에 승인된 C++20 이라는 C++ 규격에 popcount() 라는 함수가 추가되었고, 제 기억엔 이때부터 곳곳에 POPCNT 명령셋을 필요로하는 경우가 많아졌습니다. 윈도11 뿐만 아니라 리눅스 배포판에서도 마찬가지입니다.

POPCNT 는 비트가 세팅된 개수를 세는 명령입니다. 원래는 루프 돌리면서 복잡하게 계산해야 했는데 CPU의 명령셋 하나로 계산할 수 있게되고 그만큼 매우 빠르게 계산됩니다. 이 명령은 해시 함수에서는 널리 사용되는 기능인데 이제 추가되었네요.

popcnt(0x0) = 0

popcnt(0xff) = 8

popcnt(0xffff) = 16

popcnt(0xffffffff) = 32

와 같은 결과를 얻습니다.

※ SSE 4.2

SSE4.2 의 주된 변경점은 CRC32C 와 STTNI 가 추가되었습니다.

- CRC32C 는 CRC32 의 변형으로, iSCSI 에서 체크섬으로 사용합니다. RFC 3720 에 정의되어있습니다. 쉽게 말하면 하드디스크에서 배드섹터 같은거 검출할 때 사용하는 명령으로 매우 자주 사용됩니다.

- STTNI 는 String and Text New Instructions 으로 불리는 문자열 비교 연산 명령셋입니다. 역시 매우 자주 사용됩니다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

그 두번째. Part 1과 유사하지만, 구도를 조금 다르게 잡았다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

미소녀 만화 그림체의 LoRA 를 받아 생성한 그림이다. 미소녀 만화 그림체로 그려주는 LoRA 는 많지만 내가 사용하는 모델에 잘 어울리는 LoRA 는 찾기 힘들다. 사진에 사용한 LoRA 도, LoRA 소개 이미지는 아래 그림과 딴판이었다. 즉 이런 LoRA 를 발견한건 상당한 운이 있었던 셈.

LoRA 가 학습을 강하게 했는지, 다른 형태의 이미지를 생성할 수는 있지만, 프롬프트를 많이 바꾸지 않으면 유사한 이미지들이 많이 나온다. 이것저것 해보다가 아래와 같은 형식이 가장 예쁘게 나왔다. 뭔가 귀족풍의 아가씨를 만드려고 하는 내 의지와 맞았다.

이 글은 Part 3까지 업로드 예정이다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

리본 형태의 나비넥타이. 의외로 자주 보는 넥타이 형식인데, 이 형태가 SD 에서는 나오질 않았다. 나왔다 해도 조금 이상하게 나오기도 했다.

그래서 LoRA 를 만들어서 구현해 봤다. 인터넷에서 유사한 이미지들을 찾고 그림판에 붙이고 자르고 그려 넣어서 그럴듯한 이미지를 만들고, 이 이미지로 LoRA 를 만든다. LoRA 를 사용해 다시 이미지를 만들고 다시 학습시켜서 LoRA 만들고. 이걸 반복하다 보면 만족할만한 품질의 LoRA 가 나온다.

대략 모양이 나오게 만들었으면 이후 디테일을 높이고 이것저것 장식을 만들면 완성. 말이 쉽지 약 52시간 정도 걸렸다. 일주일 정도 걸린 셈. 그렇게 해서 나온게 아래 이미지들이다.

만들고 나니 뿌듯하다.

- 글쓴시간

- 분류 기술,IT

메모리에 나와있는 메모리 스펙중 하나다.

※ "2Rx8" 이면 아래와 같은 의미다.

- 2R 은 2개의 Rank 으로 구성 (듀얼랭크라고 읽는다)

- x8 은 8개의 영역을 하나의 뱅크로 구성

※ 보통 소비자용 메모리에서 2R 이면 양면램을 의미한다. 앞/뒤로 메모리가 달려있고 각각 1개의 랭크로 구성되어있기 때문이다. (양면 메모리와 2R 는 다른 의미다. 양면 메모리도 1R으로 만들 수 있다)

※ x16은 16개의 메모리 영역이 한개의 뱅크로 구성되어있다는 의미로, x8 메모리보다 더 느리다. 같은 메모리 모듈인데 뱅크 구성 단위가 낮으면 그만큼 메모리에 접근할 수 있는 공간이 늘어나기 때문이다. 이게 고속 메모리 연산이 필요한 작업, 예를 들어 게임에서는 성능차이가 많이 난다. x16이라고 소비자가격이 낮은건 아니기 때문에 반드시 x8 을 구매하자. 서버급 메모리에서는 x4 도 사용하곤 한다.

※ 그외에도 x8 메모리와 x16 메모리를 혼용하는것도 권장하지 않는다. 일부 구형 마더보드에서는 아예 인식 자체가 안되기도 한다. 따라서 성능 좋고 호환성 좋은 x8 메모리를 구매하는 것이 좋다.

- 글쓴시간

- 분류 기술,IT

Model4 킹 아서 는 중국의 Geometric Future 사에서 출시한 미드 타워 케이스다. 케이스가 하나 더 필요해서 구매했다. 3RSYS 에서 수입해 판매하는 제품이다. 120mm 팬 3개 포함해서 8.4 만원. 필자는 팬 없이 땡처리하는걸 구매해서 4.4만원에 구매했다. 이 케이스에는 기본팬을 제공하지 않는다. 그래서 수입사에서 Silence GI 120 ARGB 팬과 같이 판매하고 있다. 팬 가격을 감안하면 땡처리라 해서 딱히 저렴하지는 않다.

수직장착되는 가장 저렴한 케이스를 사려고 한건데, 큰 기대 안하고 구매 했지만 써보니 좋았다. 광고에 있는 4가지 방법으로 사용할 수 있어서 좋다는 이야기를 하려는게 아니라, 조립할 때 그냥 느낌이 좋았다. 나사의 구멍도 잘 맞았고, 나사가 헛도는거 없이 잘 돌아갔고 슬롯 위치도 딱 맞는다. 필자는 이런 기본에 충실한 케이스를 좋아한다. 강판 두께도 1T / 1.2T 라서 꽤 묵직하다. 디자인도 굉장히 예쁘고 내부 공간이 35리터나 되는 꽤 큰 케이스임에도 아담해 보인다.

기본적으로 추천해주고 싶은 케이스이고 GEO메트릭퓨처라는 회사를 좋게 볼 수 있게 만든 제품이다. 4.4만냥에 이런 제품을 구매하는건 좋은 선택이다.

하지만 몇가지 단점(?)도 보인다. 이후 다른 버전 나올때에는 보완해서 나왔으면 한다.

- 출시할때는 10만원대 꽤 비싼 제품이었던걸로 기억하는데 재활용 가능한 슬롯 커버를 3개만 주는건 좀 의외다. 이건 반드시 개선되어야 한다. 10만원대 케이스에는 모든 슬롯에 재활용 가능한 슬롯 커버를 주어야 한다.

- 기본 구성품에 팬이 없다. 이걸 감안하면 꽤 비싼 제품인 셈이다. 필자의 경우 120mm 팬이 남아있는게 많아서 상관 없었지만, 처음 이걸 구매하는 사람에겐 번들 팬이 없는건 구매를 망설이게 하는 요소다. 그나마 수입사에서 팬과 같이 판매하는건 다행이다.

- 전면 메쉬 패널에 팬을 못 단다. 물론 그냥 붙이면 되지만 나사로 조이는 건 못한다. 측면 패널에도 팬을 달 수 없다. 이부분은 개선되어서 나왔으면 한다.

- 파워 끼우는 곳을 보강해줬으면 한다. 외국의 리뷰 영상을 보면 파워 연장선 부분이 우리나라 출시 제품과는 달랐던걸로 생각된다.

- 매뉴얼을 기본 제공하지 않는다. 하지만 공식 홈페이지에서 PDF 형식의 영문 매뉴얼을 다운받을 수 있고, 읽어 보면 꽤 자세하게 나와있다. 하지만 이걸 보기 전까지는 꽤 헤멜 것이다.

- 글쓴시간

- 분류 기술,IT

PC 케이스에서 조립하다 보면 나사에 의한 도색 벗겨짐이나, 드라이버를 다루다 긁힘등이 발생한다.

잘 안보이는 곳이라면 상관 없겠지만, 좀 세게 긁혔으면 여간 신경쓰이는게 아니다. 정말 작게만 벗겨졌어도 거기만 보이니 말이다.

그래서 완벽하지는 않겠지만, 그래도 간단하게 보수할 수 있는 방법이 있다. 다름아닌 펜 처럼 쓸 수 있는 페인트를 사용하는 거다.

인터넷에서 찾아보니 쓸 수 있는건 아래와 같은 제품 정도다.

1. 페인트 마카

2. 블랙보드 마카

3. 초크펜

4. 차량용 붓 펜

"흰색" 케이스라고 해도 미묘하게 색상이 다르기 때문에, 아주 가까이에서 보면 색이 다르다는걸 인지할 수 있다. 이것까지 해결하려면 색상을 맞춰야 하는데, 그게 사실상 불가능하다. 도색의 색상 코드 알아내는게 쉬운일일까.

필자가 가장 추천하는건 페인트 마카이지만, 블랙보드 마카도 괜찮다. 초크펜은 말 그대로 분필이라, 사용할 수 있는 경우가 갈릴 것 같다. 다이소나 알파문구에서 천원~이천원에 구입할 수 있다. 세가지 모두 케이스는 물론 측면 유리 도색에도 적당히 잘 써진다. 구매할때 유성인지 수성인지 확인하고 구매하자.

차량용 붓 펜은 흰색이라도 색상코드가 다른게 많다. 따라서 색상을 정확이 맞출 수 있는 가능성이 있지만, 실제로 하기엔 쉽지 않을거 같다. 비싸기도 하고 말이다.

- 글쓴시간

- 분류 기술,IT/하드웨어 정보

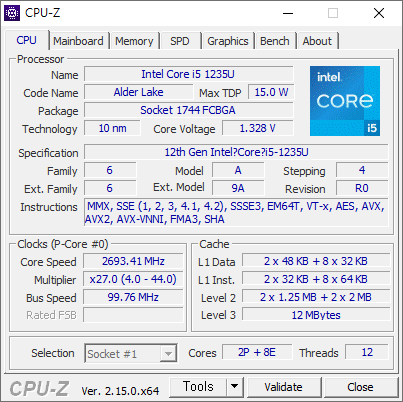

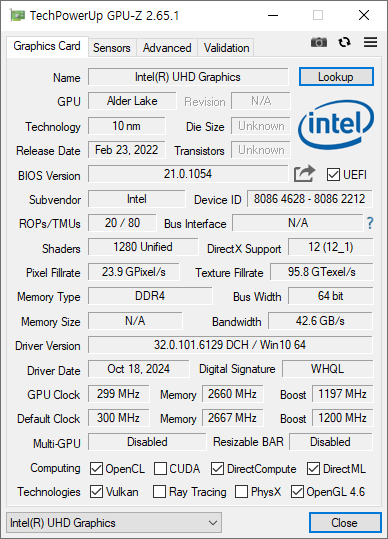

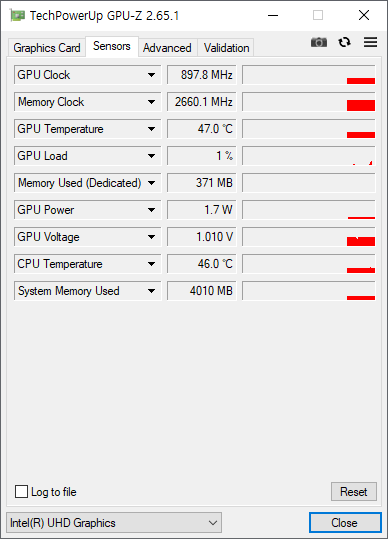

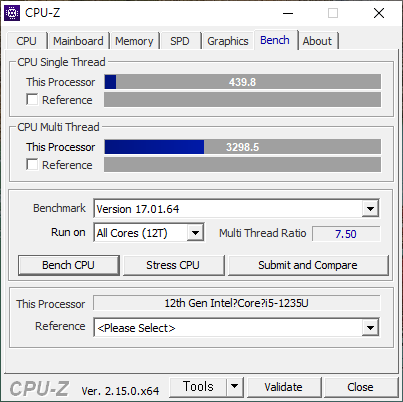

우연히 사용해본 CPU. 12세대이지만 생각보다는 많이 느렸다.

E 코어는 8개이지만, P 코어가 2개다. 따라서 고성능을 필요로 하는 작업(예를 들어 게임)에는 적합하지 않다. 그래도 E코어가 8개나 들어있기 때문에 일반적인 작업에는 충분한 성능을 보인다.

하지만 실제 사용해본 결과 뭔가 느리다. 마더보드 설정이 잘못되었을지도 모르겠다. 아래 벤치 마크 점수도 이 시스템에서는 유독 낮게 나왔다. 쿨링솔루션이 좋지 않아 발열도 제대로 해결하지 못하는것 같기도 하다.

- 글쓴시간

- 분류 기술,IT/하드웨어 정보

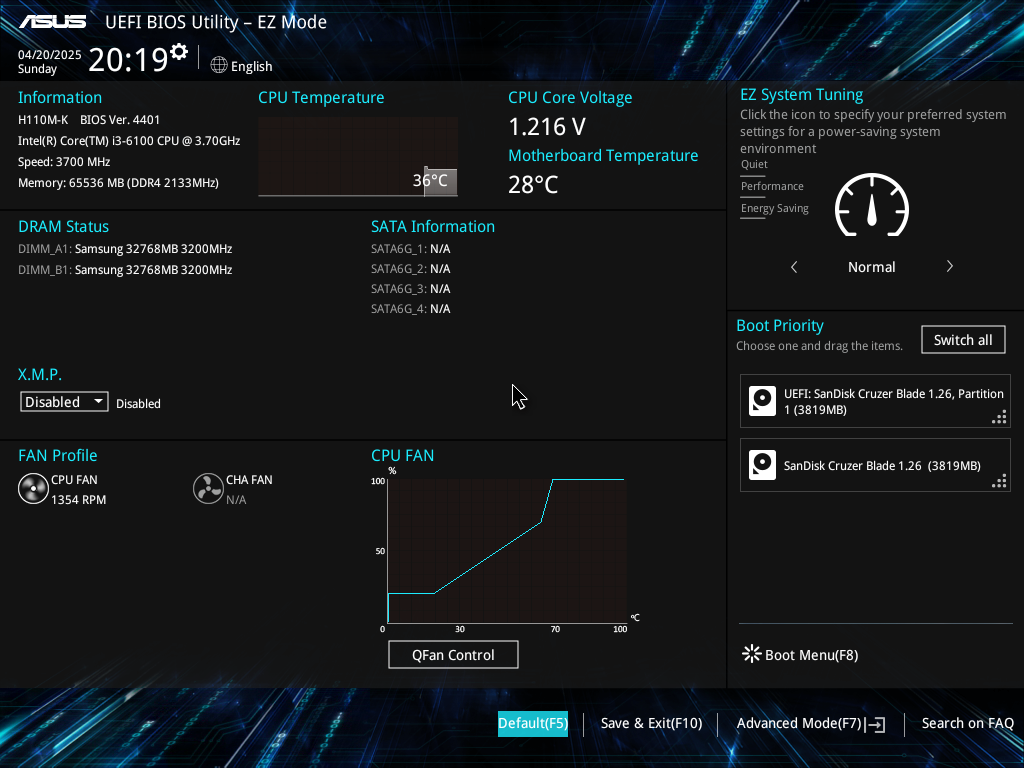

예전에 32GB 메모리를 구매한 이후 H110 마더보드에서 32GB 메모리 모듈이 인식될지, 총 64GB 메모리를 사용할 수 있을지 궁금해지긴 했다. 그리고 될것 같았다. 하지만 예전에 구매했던 H110M-K 2개는 지금은 내가 사용하지 않기 때문에 확인을 할 수 없었다.

우연히 H110M-K 를 하나 더 구했다. 원래 이 블로그의 서버를 바꿀 생각으로 mATX 마더보드 저렴한걸로 구매할 생각을 하고 있었는데 마침 이 물건이 나왔다. H110M-K 마더보드에 좋은 기억이있기 때문에 주저하지 않고 구매했다. 마더보드와 i3-6100 CPU를 포함해 1만냥에 당근에서 구매했다. 이정도면 저렴하게 잘 구매한거 같다. 테스트해 본 결과 보드와 CPU 에 이상 없다.

일단 64GB 메모리는 H110M-K 마더보드의 공식 스펙으로는 지원되지 않는다. 스펙에는 지원되는 메모리가 최대 32GB 까지라고 적혀있다.

ASUS H110M-K 의 메모리 스펙. 최대 32GB 까지 지원한다.

하지만, 마더보드에 최신 바이오스 (4401 버전)를 사용하고, 32GB 메모리를 2개를 설치하면 아래와 같이 제대로 인식되고 사용할 수 있다.

H110M-K + 64GB Memory (32GB x 2)

스카이레이크 PC중 스펙이 낮은 H110 + i3-6100 조합에서도 64GB 메모리를 사용할 수 있으니, 그 상위 제품들은 사용할 수 있을 것이라 생각한다.

인터넷에서 "Skylake/Kabylake 128GB Memory Support" 또는 "Skylake/Kabylake 32GB Memory Module Support" 쳐보면 "No" 라고 답변한 글이 최근에도 제법 있는데, 이렇게 "Yes"라고 이야기 하고 싶은거다.

----

Skylake / Kabylake 에서 32GB 메모리 모듈 및 128GB 메모리 사용하기

- 글쓴시간

- 분류 자동차

아방이 뒷 브레이크 패드를 교환했다. 보통 50000 KM 마다 교환한다. 이번이 두번째다.

브레이크 패드 교환은 블루핸즈에서 하는것 보다 근처 카센타 가서 교환하는게 더 저렴하다. 많이 저렴하다.

우선 인터넷으로 차량에 맞는 패드를 구매. "뉴아반떼 XD 1.6 (ABS) 용 브레이크 패드 뒤 라이닝"로 상신 브레이크의 부품번호는 SP1062 이다. 상신브레이크 패드 중에서 가장 저렴한걸로 골랐다. Hi-Q 브랜드 말하는거다. 가격은 1.1만냥. 1세트에 4개 들어있다. 배송받아보면 생각보다 작았다. 손바닥 만하다고나 할까. 참고로 앞바퀴용 브레이크 패드의 부품번호는 SP1152 다.

카센타에 가서 교환. 근처 자주가던 카센타가 문을 닫는 바람에 멀리 갔다. 공임은 3만냥이라고 했다. 친절하고 잘 해주셨다. 시간은 20분 정도 걸렸다.