윈디하나의 블로그

윈디하나의 누리사랑방. 이런 저런 얘기

138 개 검색됨 : 기술,IT/스테이블 디퓨전 에 대한 결과

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

Stable Diffusion 3 Medium

Stable Diffusion 3 Medium 이 오픈소스로 릴리즈 되었습니다. ComfyUI 에서는 지원되고 아직 WebUI 에서는 지원안되지만 조만간 지원될걸로 생각합니다. ComfyUI 는 제작사인 Stability AI 에서 직접 지원해줬네요.

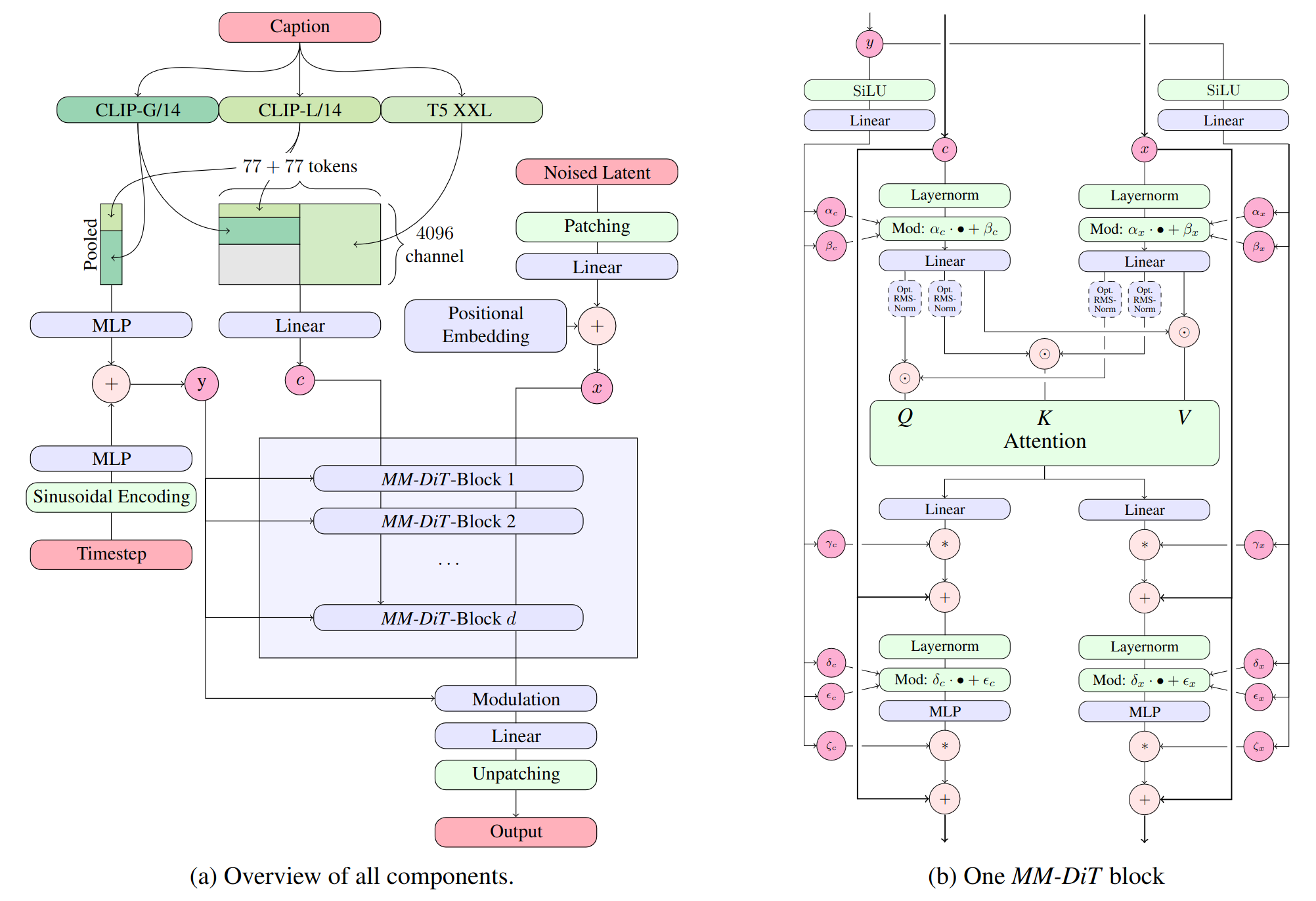

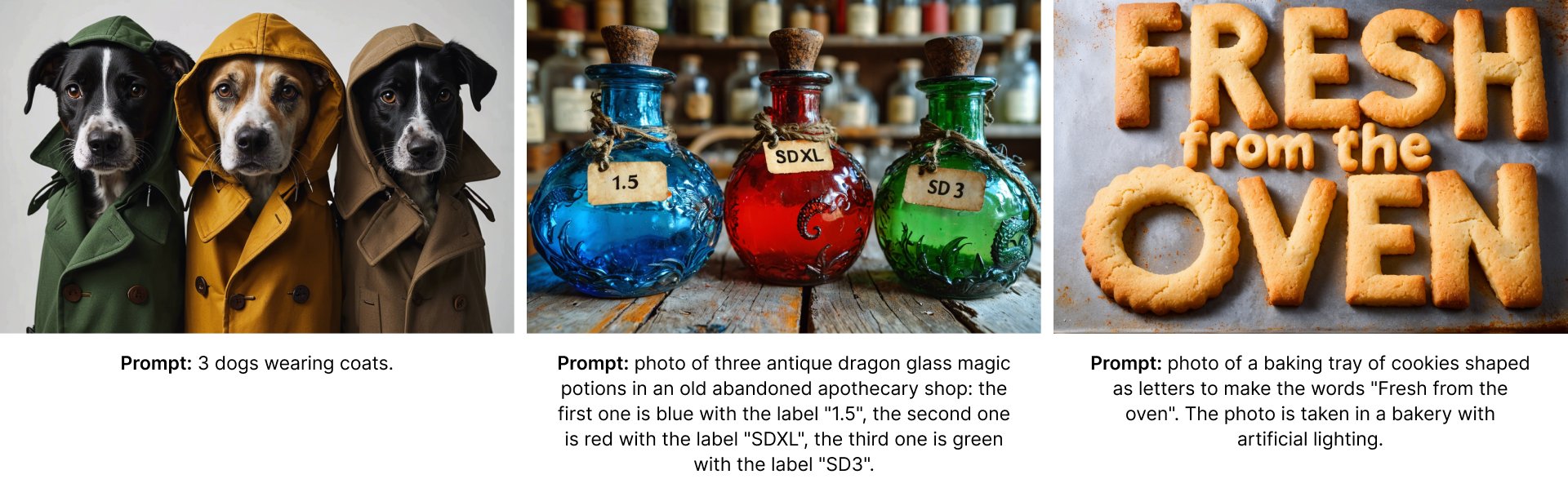

CLIP이 3가지(CLIP-G, CLIP-L, T5 XXL)이고, U-NET 구조를 가지지 않습니다. MMDiT (Multimodal Diffusion Transformer) 모델이라고 설명하네요. 파라메터는 20억개로 SDXL 의 26억개보다는 적지만, 굉장히 많은 개선점이 있습니다. 가장 눈에 띄의는건 텍스트를 제대로 인식해 출력해준다는 거네요. nVidia 와의 협업으로 TensorRT 를 사용한 성능 향상도 눈에 띄입니다.

실행시킬때 필요한 PC사양, 성능은 SDXL 과 크게 다르지 않을것 같네요. FP8 으로 줄인 모델을 사용하면 더 빠르게 사용할 수 있을 걸로 생각합니다.

WebUI 에서 포팅 중이긴 한데 아직 좀 더 기다려야 합니다. 대충 보니깐 현재 구현된건 ComfyUI 보다 많이 느리다고 하네요. Karras 스케줄러와도 안 맞는다고 합니다.

단 라이선스 때문에 말이 많네요. "크리에이터 라이선스"나 "상업 라이선스"는 유료인가 봅니다. 그리고 "비상업적 라이선스" 부분도 좀 애매한 부분이 있어, CiviAI 에서 이 부분에 대한 명확한 해명을 요구하고 있네요. 현재 라이선스대로라면 CivitAI 처럼 서비스 하는건 불가능하나 보네요.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

해 지는 저녁 노을을 배경으로 한 여인의 실루엣 사진을 한번 만들어보고 싶었다. 이런 구도는 괘 흔한 거긴 하지만, 이런걸 만들려면 색상의 대비를 표현해줄 LoRA 가 필요한데, 마침 하나 올라왔다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

긴 메이드 복. 짧은 메이드 의상보다 자수가 더 들어갔다. 이정도멘 하녀가 입는 옷이 아닐듯.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

갑자기 생성해보고 싶어서 만든 메이드. 짧은 의상편.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

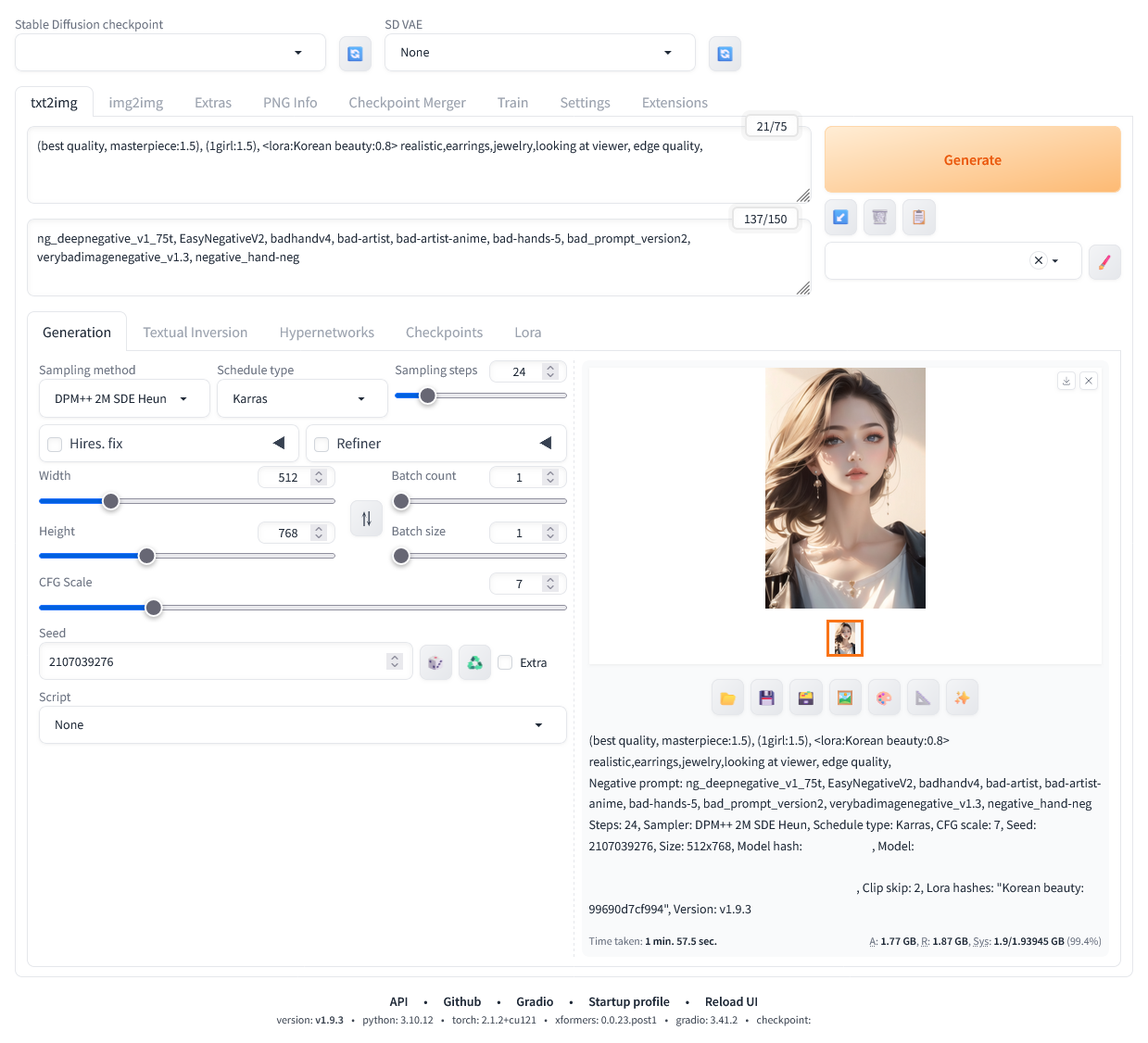

한국의 미녀를 만드려고 했지만, 잘 안되었다. 금발을 포기해야 하는데 그게 잘 안되는 셈. 그래도 맘에 드는 그림이 생성되어 좋았다.

요즘에 많이 생성하는 이미지가 애스콧(ascot)을 착용한 미녀의 이미지다. 애스콧은 여성 정장 넥타이 정도 되는데 근대에는 별로 유행하고 있지 않다. 스카프와 유사하지만 매듭이 있다. 미녀 #7 에 있는 넥타이가 모두 애스콧이다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

수영복 사진은 잘 안올리려고 했는데, 마침 좋은 LoRA 가 보여서 한번 생성해보았다. 이런 그림에는 슈트로 해야 하기 때문.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

정복이란 "의식을 행할때 입는 예복"을 말한다. 여성용 정복이라함은 블레이저, 스커트, 블라우스, 스타킹, 펌프스 정도로 되어있지만 조금 다르게 생성해 보았다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

마법사 이미지를 만들어보았다. 마침 재미있는 LoRA 도 발견하고 해서 말이다. 생각보다는 그럴듯하게 나와 올려본다.

원피스 드레스에 장신구도 좀 넣어보려 했지만 웬지 마법사 이미지하고는 맞지 않아 넣지 않았다. 스태프도 뭔가 고대 현자 스러운 나무 스태프를 넣어보려 했지만 잘 안되었다. 약간 아쉬움이 있다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

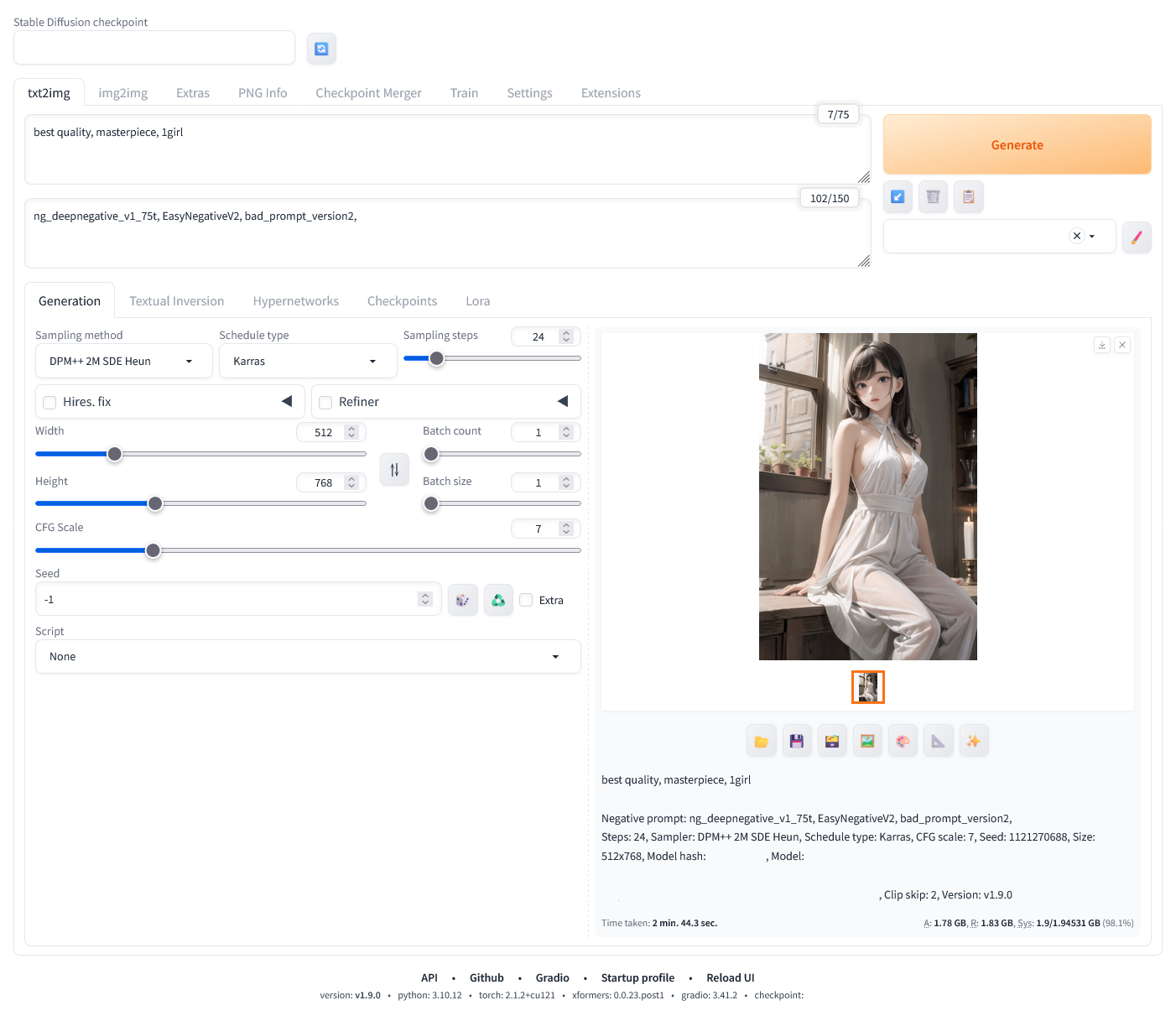

※ 여러가지 시행착오끝에 아래와 같은 512x768 이미지를 GT 1030 에서 2분대에 생성할 수 있도록 했다. 작년 이맘때 생성한게 10분 대였다는걸 감안하면 많은 발전이다. 그만큼 기술이 늘었다는 셈이다. 이 방법은 아마도 2G VRAM 을 가진 모든 nVidia 계열에서 사용할 수 있을거 같다.

※ 하는 방법을 적어 놓는다.

1. Ubuntu 22.04 를 설치하고 nVidia 그래픽 카드 드라이버를 설치한다. 이 글을 쓰는 시점에서 드라이버 버전은 550.67 이다. 윈도에서는 이 방법이 되지 않는다.

2. OS 가 띄워진 후에도 VRAM 2GB 를 온전히 비워질 수 있도록 한다. 필자의 경우 모니터 연결은 내장 그래픽을 사용했다.

3. Stable Diffusion WebUI 를 설치하고 실행한다. 옵션은 "--medvram --listen --xformers" 을 준다.

glibc version is 2.35

Check TCMalloc: libtcmalloc_minimal.so.4

libtcmalloc_minimal.so.4 is linked with libc.so,execute LD_PRELOAD=/lib/x86_64-linux-gnu/libtcmalloc_minimal.so.4

Python 3.10.12 (main, Nov 20 2023, 15:14:05) [GCC 11.4.0]

Version: v1.9.0

Commit hash: adadb4e3c7382bf3e4f7519126cd6c70f4f8557b

Launching Web UI with arguments: --medvram --listen --xformers

Loading weights [********] from Model.safetensors

Running on local URL: http://0.0.0.0:7860

To create a public link, set `share=True` in `launch()`.

Startup time: 7.1s (prepare environment: 1.4s, import torch: 2.4s, import gradio: 0.6s, setup paths: 1.2s, import ldm: 0.1s, initialize shared: 0.1s, other imports: 0.3s, list SD models: 0.1s, load scripts: 0.4s, create ui: 0.4s).

Creating model from config: /home/windy/stable-diffusion-webui/configs/v1-inference.yaml

Applying attention optimization: xformers... done.

Model loaded in 1.6s (load weights from disk: 0.5s, create model: 0.3s, apply weights to model: 0.5s, calculate empty prompt: 0.2s).

4. 이미지를 생성한다. 아래 화면 참조하자. 프롬프트는 75 토큰 이하, 네거티브 프롬프트가 반드시 75토큰이상 150토큰 이하이어야 한다. (왜그래야 하는지는 모르겠다)

4-1. 아래와 같이 화면에 표시된다.

100%|████████████████████████████████████████████████████████| 24/24 [02:33<00:00, 6.40s/it]

Total progress: 100%|██████████████████████████████████████████████| 24/24 [02:36<00:00, 6.54s/it]

Total progress: 100%|██████████████████████████████████████████████| 24/24 [02:36<00:00, 6.36s/it]

4-2. VRAM 사용량은 아래와 같다. 1952 MB 사용한다.

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 550.67 Driver Version: 550.67 CUDA Version: 12.4 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA GeForce GT 1030 Off | 00000000:01:00.0 Off | N/A |

| N/A 53C P0 N/A / 19W | 1955MiB / 2048MiB | 100% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

+-----------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=========================================================================================|

| 0 N/A N/A 5895 C python3 1952MiB |

+-----------------------------------------------------------------------------------------+

4-3. 생성 완료된 후 나오는 텍스트는 아래와 같다.

best quality, masterpiece, 1girl

Negative prompt: ng_deepnegative_v1_75t, EasyNegativeV2, bad_prompt_version2,

Steps: 24, Sampler: DPM++ 2M SDE Heun, Schedule type: Karras, CFG scale: 7, Seed: 1121270688, Size: 512x768, Model hash: ********, Model: Model, Clip skip: 2, Version: v1.9.0

Time taken: 2 min. 44.3 sec.

A: 1.78 GB, R: 1.83 GB, Sys: 1.9/1.94531 GB (98.1%)

5. 정말 아슬아슬하게 생성되는 셈이다. --lowvram 과 아닌건 성능 차이가 많기 때문에 필자는 이렇게 사용하고 있다.

----

2024.05.19 추가

- 이렇게 세팅하는 경우 LoRA 는 사용 가능하다.

- 배치는 사용할 수 없다. VRAM 이 몇십메가가 모자르기 때문에 사용이 안된다. 아깝다.

- Stable Diffusion WebUI Forge 라는 걸 사용하면 2GB 에서도 원활히 생성할 수 있다. 사용방법도 Stable Diffusion WebUI 와 비슷하다.

- 오늘 생성해보니 이유는 모르겠지만 시간이 줄었다. 2분이 안걸린다.

- torch: 2.1.2+cu121, xformers: 0.0.23.post1 을 사용해야 한다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

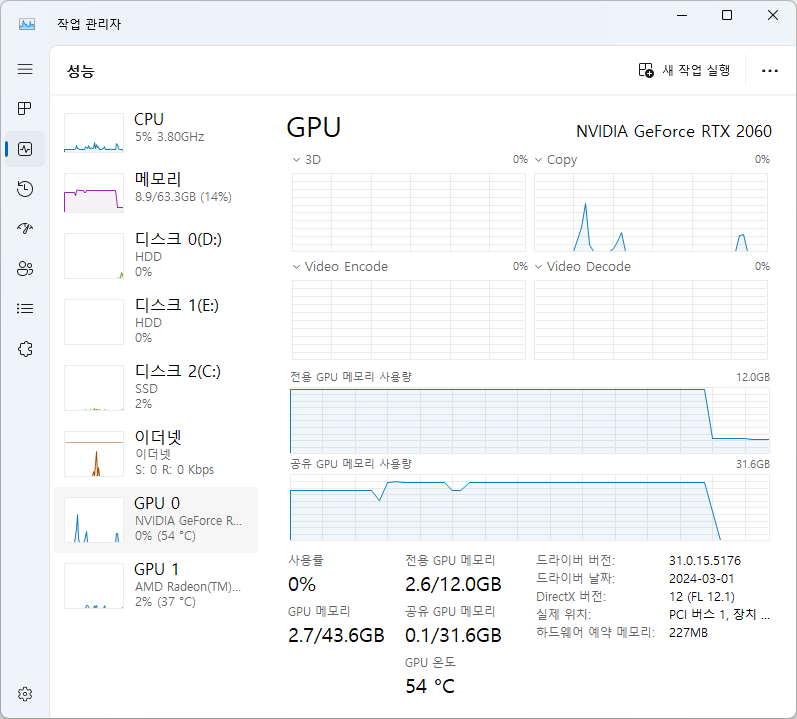

기존에 4K 이미지 생성하는걸 실패했다는 글을 작성한적이 있다. 시스템 메모리를 업그레이드하면 되지 않을까 했었는데, 실제 메모리 업그레이드를 단행해 보았다. 그리고 4K 이미지 생성되었다.

※ 테스트 사양

메모리: VRAM 12GB, SYSTEM RAM 64 GB

SD WebUI: v1.9.0, "--xformers --no-half-vae" 옵션

※ 테스트

③ 544 x 960 → 2176 x 3840 변환(Hires. fix)작업: 시간: 15m 42s, A: 26.46 GB, R: 42.11 GB, Sys: 12.0/12 GB (100.0%)

-> Extra 탭에서 변환하는 것보다 Hires. fix 으로 생성하는게 디테일이 더 살아있다. 4K 이미지 생성시 시스템 메모리 64GB 는 필수다.

※ 메모리 사용량

마지막 단계에서 아래와 같이 사용한다. 이때 위에 나온 "A: 26.46 GB" 를 사용하는 셈이다.

----