윈디하나의 블로그

윈디하나의 누리사랑방. 이런 저런 얘기

2451 개 검색됨 : 분류 전체보기 에 대한 결과

- 글쓴시간

- 분류 기술,IT/하드웨어 정보

SilverStone SST-FLP02W

재미있는 케이스가 나와서 올려본다. 실버스톤의 FLP02 라는 모델이다.

레트로감성 풍만한 케이스다. 요즘엔 플로피나 ODD 를 달 수 있는 5.25 인치 확장 슬롯이 있는 모델이 나오지 않지만, 불과 10여년전만 해도 흔했다. 게다가 20여년전에 볼 수 있었던 잠금장치를 2026년에 볼 수 있을거라고는 생각 못했다. 터보키도 구현해 놓았다. 전원 버튼도 요즘 나오는건 버튼식이라 저런식으로 구현하기 힘들었을 것 같다. 실제로 작동되는 건 20여년전의것과는 다르다. 잠금키는 리셋버튼의 잠금키고, 터보키는 PWM 조절장치라고 한다.

재미삼아 구매하기엔 너무 비싸다. 30만원 정도. 그래도 이런 케이스가 나오니 반갑긴 하다.

같은회사에서 아래와 같이 HTPC 모델인 FLP01 이 나왔다. 이것도 만만치 않는 가격이다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

근하신년 텍스트가 들어간 이미지를 만드려고 했지만, SDXL 기반에서는 텍스트는 그냥 안된다고 보는게 맞을거 같다. 그래서 그냥 없는걸로 만들었다. 마침 CivitAI 에 비슷한 이미지가 있길래 프롬프트를 기반으로 따라했다. 생각보다는 잘 나왔다.

만들고 난 후에 알았지만, 이거 기모노 기반이었다. 중국의상이 아니라 말이다. 끄긍.

- 글쓴시간

- 분류 기술,IT/하드웨어 정보

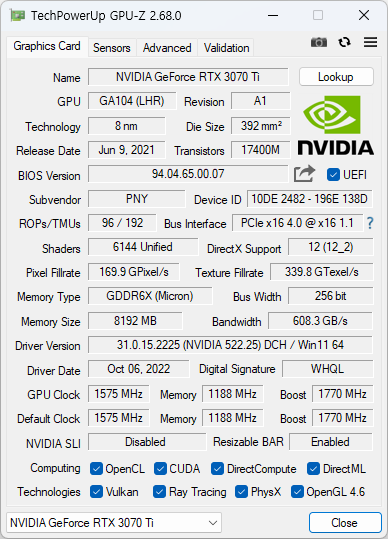

우연히 써보게 된 3070Ti 에 대한 GPU-Z 다. 생각보다 4060Ti 과 성능차이가 나지 않는다. (물론 3070Ti 가 더 좋다) GPU 메모리는 8GB vs 16GB 이니 이부분은 4060Ti 가 더 좋긴 하겠지만 말이다.

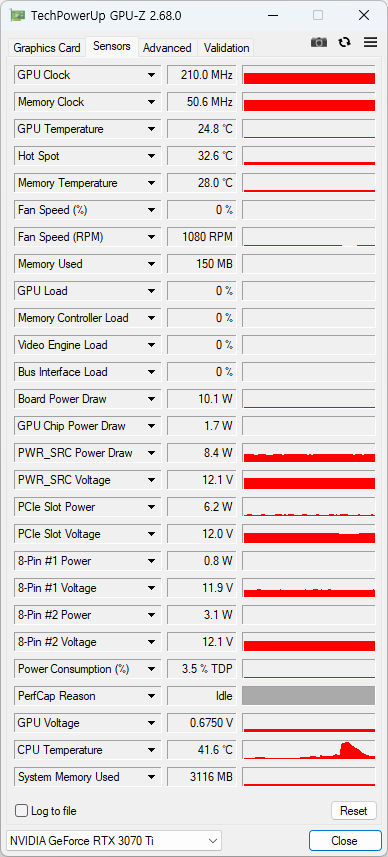

센서는 4060과 동일한 느낌.

- 글쓴시간

- 분류 기술,IT/하드웨어 정보

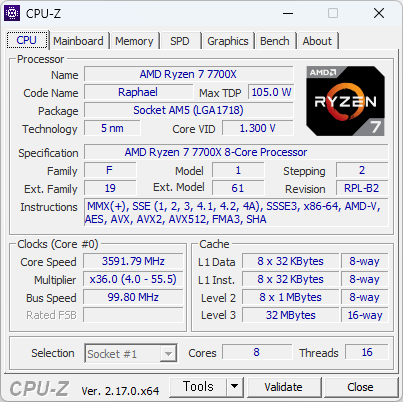

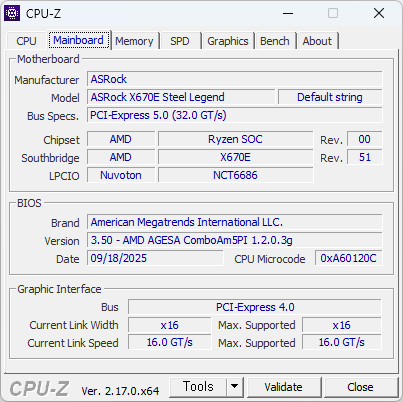

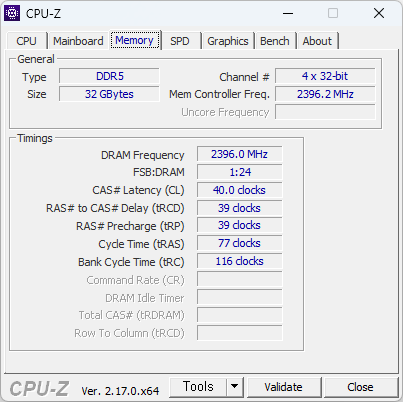

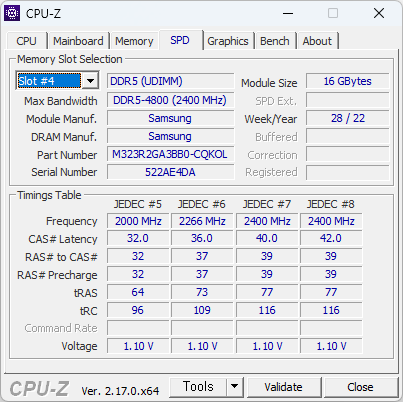

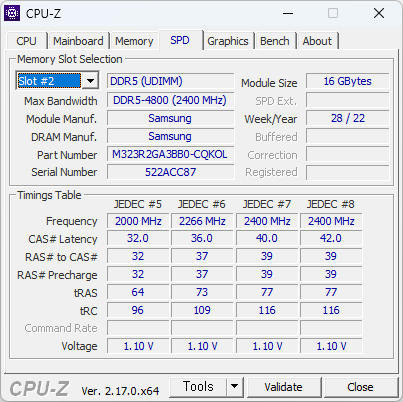

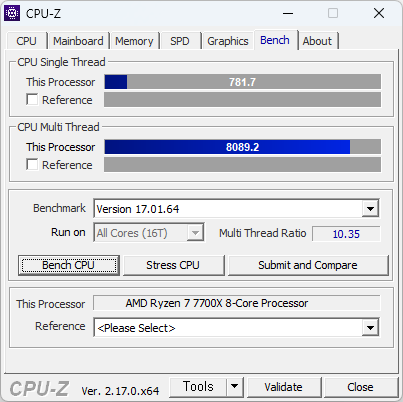

이번에 사용해본 CPU. 생각보다 빠르다. 많이 빠르다. 바꿔야 겠지만, 메모리가격이 문제다.

싱글점수가 700점을 넘는다. 현재 쓰고 있는것에 거의 80% 이상 빠르다. 이러니 빠른게 체감될 수 밖에.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

스테인드 글라스를 배경으로 만들어보았다. #4 와는 조금 다른 느낌. 역시 이런 복잡도 높은 이미지 생성할때에는 손가락이 가장 문제다.

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

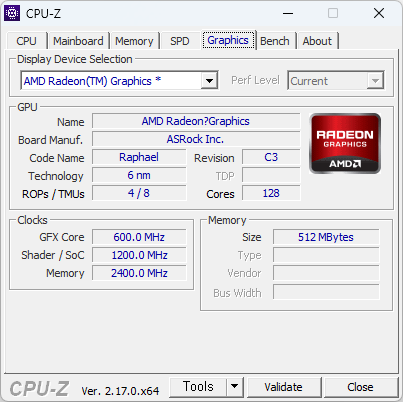

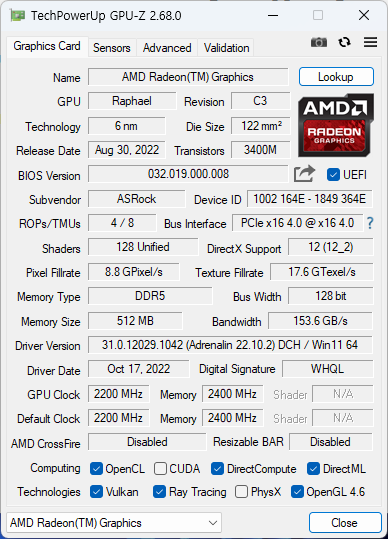

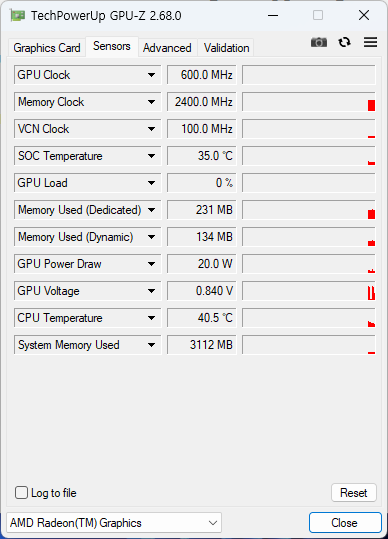

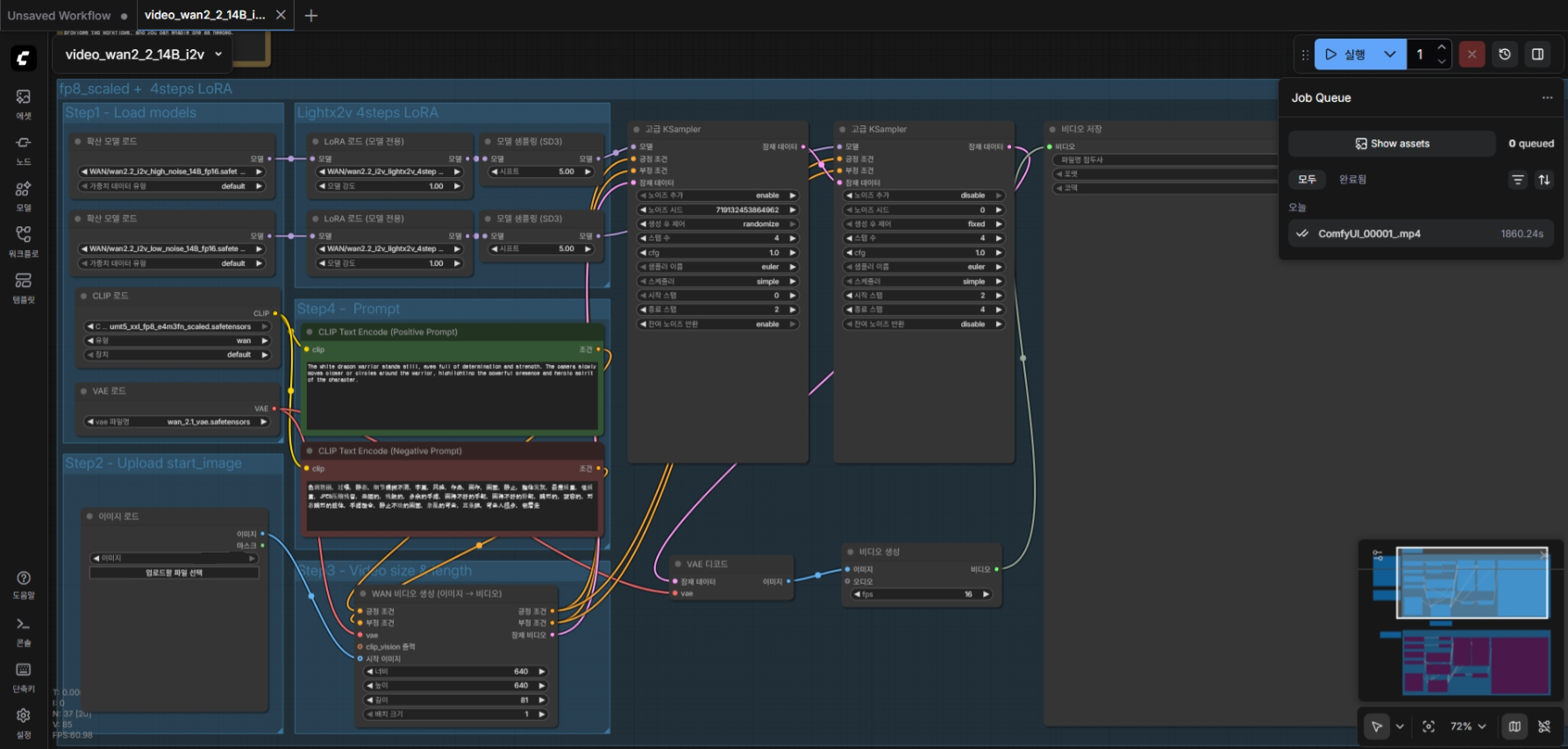

Wan 2.2 는 중국 알리바바그룹의 통이 연구소에서 개발한 시각모델이다. 2025.07.28에 공개되었다. 주로 동영상을 만들기 위해 사용한다. 오픈소스로 공개되어있다.

기존의 Wan 2.1 의 완성판이다. 이후에는 Wan 2.5 가 나올꺼고, 현재는 WAN 2.5 의 프리뷰버전까지 나왔다. 하지만 이제서야 2.2 를 써 본다.

WAN 2.2 의 기본 워크플로. 2060 12G 에서 생성에 30분 걸렸다.

사용방법은 Wan 2.1 과 비슷하다. 모델만 2.2 로 바꿔주면 되는데, Wan 2.2 부터 I2V 에서 High - Low 모델이 분리되었다. High 모델은 구도 잡는데, Low 모델은 디테일을 높이는 데 사용한다. 따라서 동영상을 생성하기 위해서는 모델 2개를 순차적으로 돌려야 한다. 또한 모델 로딩에 필요한 메모리가 2배로 들어간다. 64GB 시스템 메모리에서 간신히 로딩된다. 128GB 는 필요하다. 벌써부터 64GB 메모리가 부족할 줄이야.

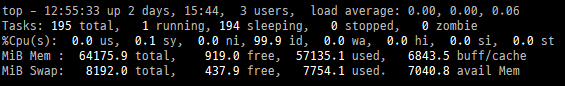

ComfyUI 0.4.0 + WAN 2.2 에서 I2V 실행후 남아있는 메모리 사용량. 스왑메모리 사용량을 감안하면 64GB 시스템에서 사실상 모자른 셈이다.

Lightx2v 에서 정제버전을 공개했다. 이를 사용하면 4 스텝으로도 충분한 품질을 얻을 수 있다고 한다. 20 스텝 -> 4 스텝 이니 5배나 빨라진 셈이다. 안쓸 이유가 없고 ComfyUI 문서에도 사용하라고 나온다.

RIFE VFI 프레임 보간을 사용해서 생성할 이미지의 FPS 를 올려주는 방법도 있다고 하는데 아직 적용은 못해봤다.

Wan2.2 Video Generation ComfyUI Official Native Workflow Example - ComfyUI

- 글쓴시간

- 분류 기술,IT/스테이블 디퓨전

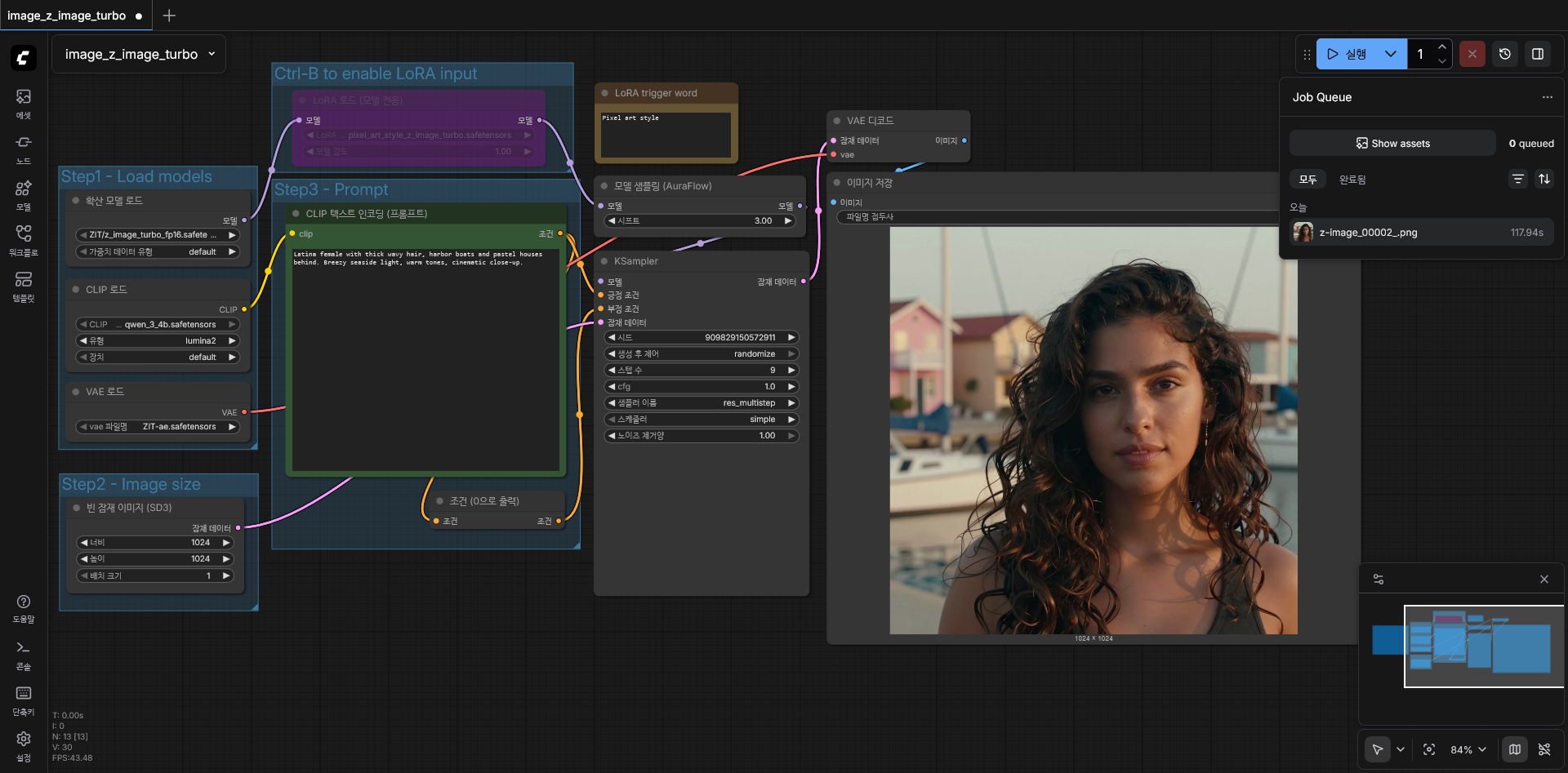

- 16GB 메모리 를 가진 소비자용 GPU 에 최적화되어있는게 특징입니다. 파라메터 개수는 6B 입니다. 오픈소스이고, Apache-2.0 라이선스라 상업적으로 사용하는 것도 자유롭습니다. 또한 이미지 생성할 시, 9개 스탭 정도로도 충분한 이미지 퀄리티를 보여줍니다.

- 현재는 Python 코드로 사용하거나, ComfyUI 에서 사용 가능합니다.

2060 12GB 에서 기본값으로 실행.

- 기본 워크플로를 사용해 생성했을때, 117.9초 소요됩니다. 1024x1024 이미지 임에도 불구하고 2060 에서는 꽤 느리기 때문에 당분간은 SDXL 을 사용할 수 밖에 없겠습니다. 조만간 5060 정도로 바꿀 지도 모르겠네요.

- 제가 가지고 있는 2060 12GB 에서 작동시키기 위해 FP16 버전을 사용했습니다. BF16 과 비교해서 성능에 큰 차이는 없습니다. (물론 그래도 할 수 있다면 BF16을 사용하는게 좋습니다) ComfyUI 실행시킬 때 "--use-sage-attention --force-fp16" 옵션을 추가로 주었고, "pip install sageattention" 명령을 주어 파이썬 패키지를 설치했습니다. sageattention 을 사용하기 위해 "apt install python3.12-dev" 패키지도 설치했죠. 최종적으로 27초로 단축되었네요.

2060 12GB 에서 기본값으로 실행. 27초 소요.

- 아직 에니메이션 풍의 이미지는 생성하기 어려워 보입니다. 뭔가 실사판 이미지를 에니로 바꾼 느낌이네요. SDXL 에 비해 사용자가 많지 않아서 그런지 LoRA 도 아직은 적게 나오고 있습니다. 하지만 앞으로는 달라질꺼라고 생각합니다. 하드웨어 요구사항에 비해, 이미지 퀄리티도 좋고 이미지 생성 속도도 빠르기 때문에 지금도 꽤 많은 곳에서 쓰기 시작하네요. 저도 바꿔볼까 생각중입니다.

Z-Image - Fast & Free Image Generator

- 글쓴시간

- 분류 시사,사회

락온이란 전투기에서 목표를 고정하고, 사격통제장치가 조준을 완료해 "미사일 발사 준비 완료"된 상태를 말한다. 조종간의 버튼 하나 누르면 이제 미사일이 발사되고 목표를 격추시킬 것이다.

- 전쟁이 아닌 상태에서 상대방 전투기에 락온을 한다는건 상대방에게 굉장히 큰 위협이다. 장전된 총을 상대방에게 겨눈것과 동일하다.

- 2025-12-07에 중국 전투기가 일본 전투기를 락온했다고 한다. 따라서 가만히 있으면 안되는 상황이다. 실수로 락온을 할 수 있는게 아니기 때문에, 목표 고정을 실수로 할 수 있는게 아니고 조준을 완료한것도 실수로 할 수 있는게 아니다. 변명의 여지가 없다. 그러기 때문에 일본에서 심각하게 보고 있는것 같아 보인다. 파일럿도 락온은 상당한 위협이라는걸 알고 있고 국제문제가 될 것이라는 것도 알고 있을 것같고 말이다.

- 뭔가 뭔가 일어날 것 같은 예감.

- 글쓴시간

- 분류 기술,IT

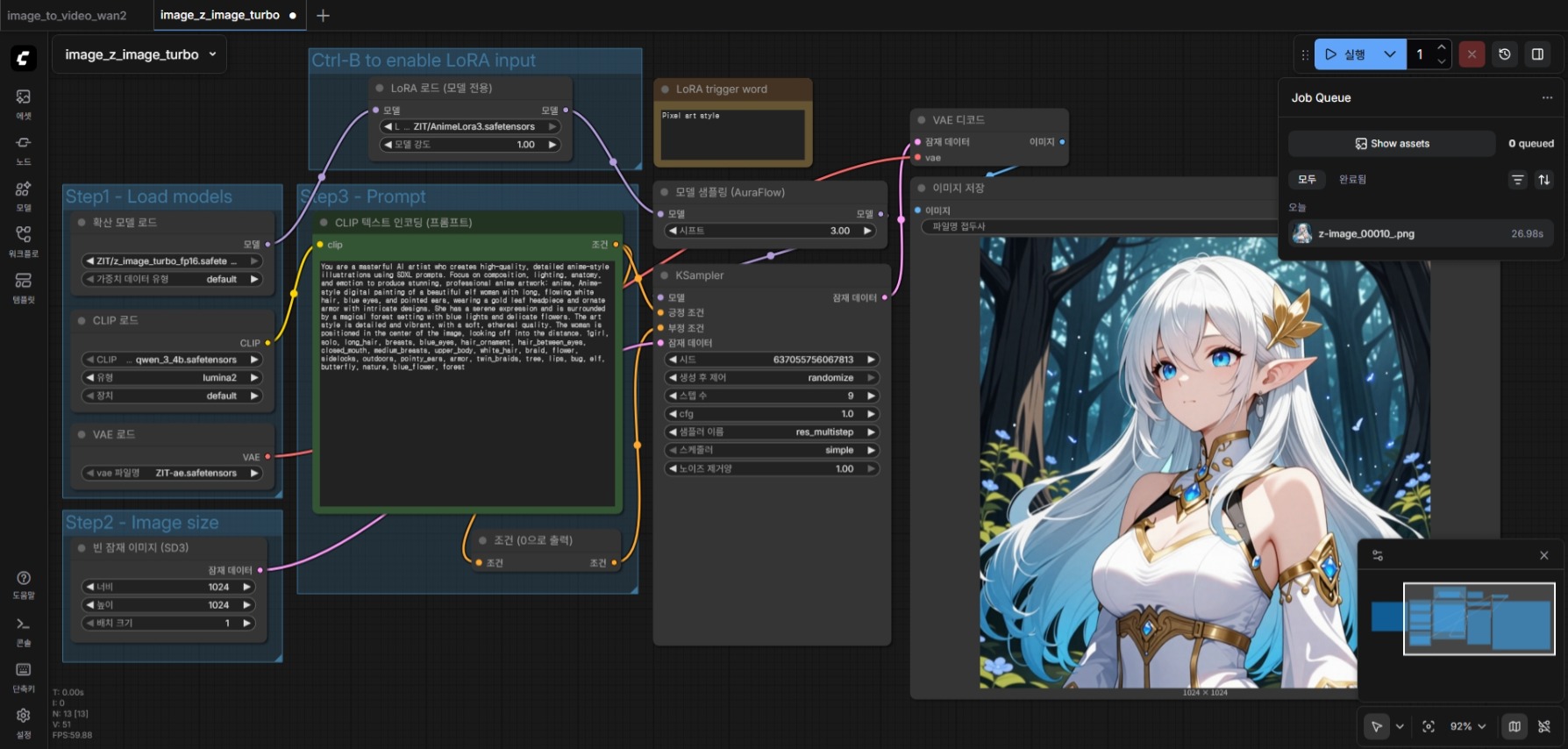

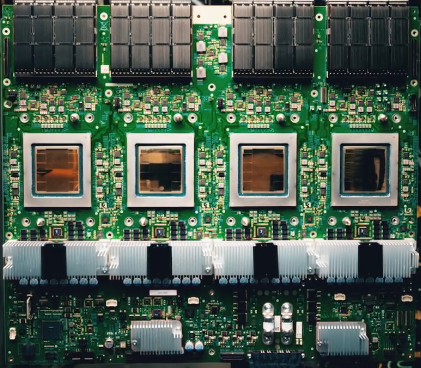

구글의 차세대 TPUs (Tensor Processing Units) 인 Ironwood 가 주목받고는 있습니다.

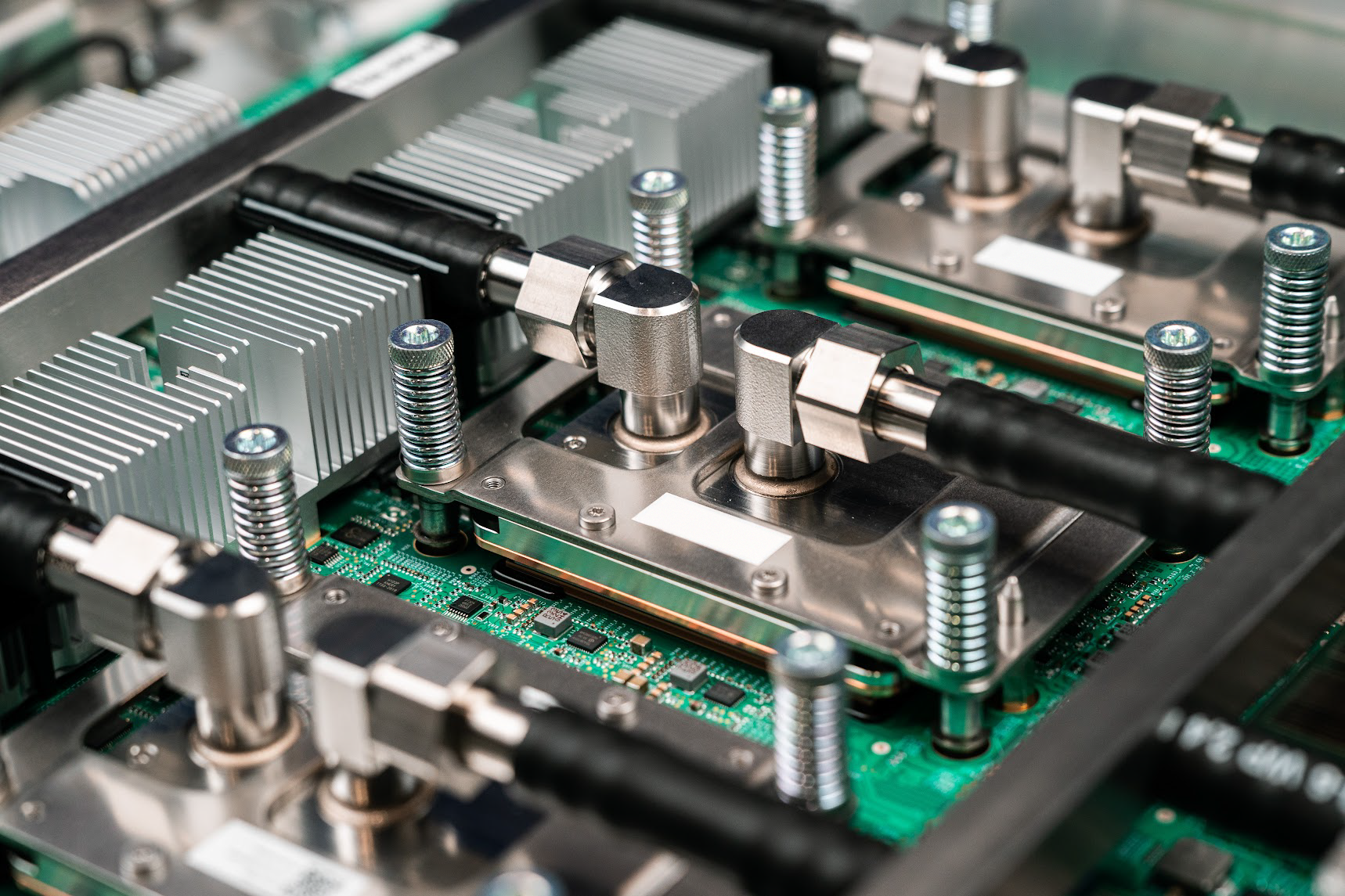

구글의 Ironwood 클러스터의 일부

하지만 뭔가 관심이 너무 과한것 같아 글을 남겨봅니다.

TPU 라는건 딱히 신기할건 없습니다. nVidia 의 GPU 에도 TPU 와 유사한 Tensor Core 가 있기도 하구요. 필요한 데이터를 미리 연산 유닛에 전부 로드시켜 놓고 파이프 라인 및 연산 어레이를 통해 동시에 연산하는거니까요. 굉장히 빠른 연산이 가능하기 때문에 GPU 던 TPU 던 많은 곳에서 이런형태의 연산 유닛이 있습니다.

Ironwood 소켓의 영상. 수냉 쿨러가 인상적이다.

TPU 는 주로 AI 추론용 칩입니다. AI 학습에서도 사용 가능하지만 매우 제한적인 용도로만 사용할 수 있습니다. 물론 AI 학습보다 AI 추론에 사용될 GPU/TPU 가 훨씬 많아질거라, TPU 가 추론용이라고 폄하하는건 아닙니다. 특히 AI 서비스가 점점 많아지고 일상생활에서도 알게 모르게 AI 를 사용하려면, 이런 형태의 추론용 칩은 앞으로도 굉장히 많이 필요하게 될겁니다. 즉 학습용 칩보다 추론용 칩이 훨씬 많이 필요합니다.

Ironwood Chip Spec

- 4614 TFLOPS (FP8)

- Memory: 192 GB HBM, 7.37 TB/s

- Interconnect: 1.2 TBps

- 9216 개의 칩을 사용한 Pod Size 구성 가능

----

Ironwood: The first Google TPU for the age of inference